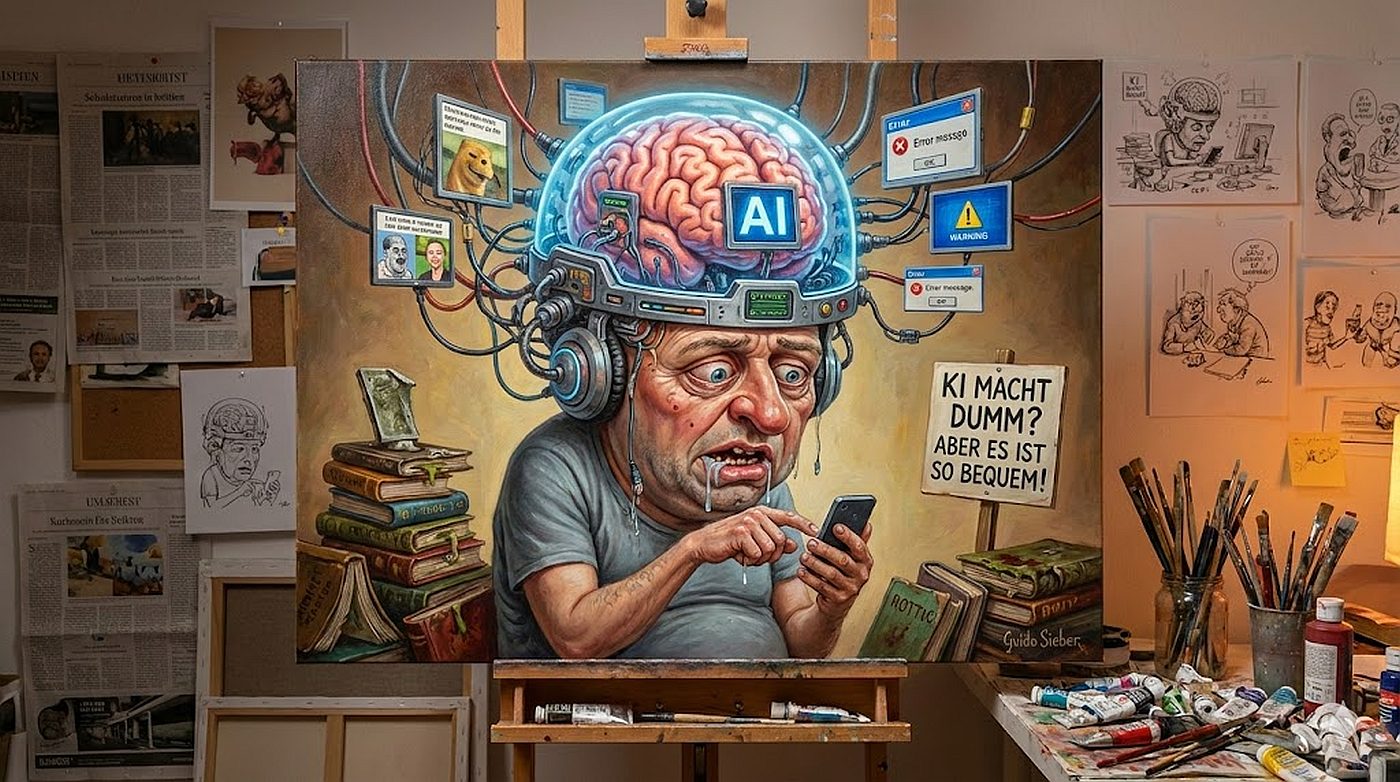

Macht KI dumm? Eine umfassende Analyse der Auswirkungen generativer Künstlicher Intelligenz auf die menschliche Kognition

1. Einleitung: Die Renaissance der kognitiven Sorgen im Zeitalter der Algorithmen

Die Menschheitsgeschichte ist geprägt von einer wiederkehrenden Dialektik zwischen technologischer Innovation und der Sorge um den Verlust menschlicher Fähigkeiten. Als die Schriftkultur die mündliche Tradition ablöste, warnte Platon im Phaidros vor dem Verlust des Gedächtnisses. Als der Taschenrechner in die Klassenzimmer einzog, prophezeiten Pädagogen den Verfall der arithmetischen Kompetenz. Doch die aktuelle Debatte um generative Künstliche Intelligenz (GenAI), ausgelöst durch die breite Verfügbarkeit von Large Language Models (LLMs) wie GPT-4, Claude und Gemini, unterscheidet sich fundamental von ihren historischen Vorläufern. Während frühere Technologien spezifische, oft mechanische kognitive Lasten (wie das Speichern von Fakten oder das Berechnen von Zahlen) übernahmen, dringt GenAI in die Domäne der höheren Kognition ein: das synthetische Denken, die Argumentationsbildung, die Kreativität und die Urteilsfindung.1

Die Frage “Macht KI dumm?” ist daher keine polemische Zuspitzung, sondern eine dringliche forschungsleitende Fragestellung, die im Jahr 2025 weltweit wissenschaftlich untersucht wird. Die Sorge ist nicht mehr nur der Verlust von Faktenwissen – dieses ist im Internetzeitalter ohnehin ubiquitär –, sondern die Erosion der Fähigkeit, dieses Wissen selbstständig zu verarbeiten und zu validieren. Kritiker wie der Neurowissenschaftler Manfred Spitzer sehen in der zunehmenden Auslagerung geistiger Arbeit eine Gefahr der “Digitalen Demenz“, eine physiologische Rückbildung neuronaler Strukturen durch Nichtgebrauch.2 Demgegenüber stehen Theorien des “Extended Mind”, die KI als notwendige Erweiterung des menschlichen Geistes betrachten, die uns von kognitiver Routinearbeit befreit, um Raum für komplexere Problemlösungen zu schaffen.4

Dieser Bericht analysiert auf Basis der aktuellen Forschungsliteratur der Jahre 2024 und 2025 die vielschichtigen Auswirkungen von GenAI auf das menschliche Gehirn. Er untersucht die Mechanismen des Cognitive Offloading, die Gefahren des Automation Bias, die neue Theorie des Hollowed Mind und die notwendigen pädagogischen Transformationen hin zur AI Literacy. Ziel ist es, jenseits der binären Logik von “gut” oder “schlecht” zu verstehen, wie sich die Architektur unseres Denkens unter dem Einfluss algorithmischer Assistenz verändert.

2. Neurobiologische Grundlagen: Plastizität und die Ökonomie des Gehirns

Um die potenziellen Auswirkungen von KI auf die Intelligenz zu verstehen, muss man die fundamentalen Arbeitsweisen des menschlichen Gehirns betrachten: seine Plastizität und seinen Hang zur Energieeffizienz.

2.1 Neuroplastizität: Das Prinzip “Use It or Lose It”

Das menschliche Gehirn ist kein statischer Speicher, sondern ein dynamisches Organ, das sich strukturell und funktionell an seine Nutzung anpasst. Dieser Prozess, bekannt als Neuroplastizität, bedeutet, dass neuronale Verbindungen (Synapsen) durch wiederholte Aktivierung gestärkt werden (Langzeitpotenzierung), während inaktive Verbindungen abgebaut werden (Synaptic Pruning).6 Lernen ist physiologisch betrachtet der Prozess des Aufbaus und der Festigung dieser Netzwerke.

Forschungen zeigen, dass tiefgreifendes Verstehen und Gedächtnisbildung eine gewisse kognitive Anstrengung erfordern – oft als “Desirable Difficulty” oder “Cognitive Friction” bezeichnet. Wenn wir uns durch ein komplexes Problem “quälen”, Informationen aus verschiedenen Quellen synthetisieren und Widersprüche auflösen, feuern neuronale Netzwerke intensiv und verändern ihre Struktur. GenAI hat das Potenzial, genau diesen Prozess des “produktiven Kampfes” zu eliminieren. Wenn ein Prompt in Sekunden eine perfekte Zusammenfassung liefert, entfällt der neuronale Reiz, der für die Festigung der verarbeitenden Areale notwendig wäre.1

Historische Analogien verdeutlichen dieses Risiko: Die berühmte Studie an Londoner Taxifahrern zeigte, dass das intensive Auswendiglernen des Straßennetzes (“The Knowledge”) zu einer messbaren Vergrößerung des Hippocampus führte, dem Areal, das für räumliche Orientierung und Gedächtnis zuständig ist. Folgestudien deuten darauf hin, dass die ständige Nutzung von Navigationssystemen diesen Trainingseffekt negiert. Übertragen auf GenAI stellt sich die Frage: Wenn wir das “Navigieren” durch Wissensräume, das logische Verknüpfen von Argumenten und das sprachliche Formulieren auslagern, atrophieren dann die entsprechenden Areale im präfrontalen Kortex und im Sprachzentrum? Neuere Studien aus dem Jahr 2025 legen nahe, dass genau dies geschieht: Eine Reduktion der kortikalen Aktivität bei Aufgaben, die vollständig an KI delegiert werden, führt langfristig zu einer Schwächung der kognitiven Reserve.7

2.2 Kognitiver Geiz und die Motivation zur Auslagerung

Das Gehirn arbeitet nach dem Prinzip des kognitiven Geizes (Cognitive Miser). Es versucht stets, kognitive Ressourcen zu schonen und wählt intuitiv den Weg des geringsten Widerstands. KI-Tools sind perfekt darauf ausgelegt, diesen Instinkt zu bedienen. Sie bieten “Reibungslosigkeit” (Frictionless Experience). Diese Bequemlichkeit ist jedoch trügerisch. Was sich kurzfristig als Effizienzgewinn anfühlt (schnellere Ergebnisse), ist langfristig ein Trainingsverlust.

Studien zur “Digitalen Demenz”, die 2025 erneut diskutiert wurden, untermauern dies. Ein hoher Konsum digitaler Medien und die Delegation von Gedächtnisleistungen korrelieren negativ mit der Aufmerksamkeitsspanne und der Gedächtnisleistung.2 Manfred Spitzer argumentiert, dass die Auslagerung mentaler Prozesse an digitale Endgeräte dazu führt, dass die neuronale Hardware mangels Nutzung verkümmert. Während Kritiker einwenden, dass das Gehirn sich lediglich spezialisiert und Kapazitäten für anderes freiwerden, zeigen aktuelle Daten, dass bei starker KI-Abhängigkeit diese “freien Kapazitäten” oft nicht für höherwertige Tätigkeiten genutzt werden, sondern brachliegen oder für passiven Konsum verwendet werden.2

3. Cognitive Offloading: Zwischen Entlastung und Aushöhlung

Der Fachbegriff für die Auslagerung von Denkprozessen an externe Werkzeuge ist Cognitive Offloading. Die Bewertung dieses Phänomens hat sich durch die Einführung von GenAI drastisch gewandelt.

3.1 Die Theorie des “Extended Mind” vs. “Hollowed Mind”

Lange Zeit dominierte die von Clark und Chalmers (1998) geprägte These des Extended Mind. Sie besagt, dass Werkzeuge (Notizbuch, Smartphone, KI) Teil unseres kognitiven Systems werden. Die Intelligenz endet nicht an der Schädeldecke, sondern erweitert sich in die Welt hinein.4 In diesem Modell ist KI ein “Exokortex”, ein externer Neocortex, der unsere Fähigkeiten potenziert.5

Doch Forschungen aus dem Jahr 2025 stellen diesem optimistischen Bild die Hypothese des Extended Hollowed Mind (des erweiterten, aber ausgehöhlten Geistes) gegenüber.9 Diese Theorie differenziert zwischen Performance (Leistung im Moment) und Competence (nachhaltige Fähigkeit).

| Konzept | Extended Mind (Traditionell) | Extended Hollowed Mind (Neu 2025) |

| Mechanismus | KI übernimmt Routineaufgaben (z.B. Rechnen), Mensch fokussiert auf Strategie. | KI übernimmt integrative Kernprozesse (Synthese, Bewertung). |

| Effekt | Kognitive Kapazität wird für Höheres frei (Cognitive Unloading). | Kognitive Prozesse werden umgangen (Cognitive Bypass). |

| Resultat | Augmentation: Der Mensch wird leistungsfähiger. | Atrophie: Der Mensch verliert die Fähigkeit zur unabhängigen Problemlösung. |

| Risiko | Abhängigkeit von der Verfügbarkeit des Tools. | Verlust der “Cognitive Sovereignty” (geistige Souveränität) und Identität als Lernender. |

Die Gefahr des Hollowed Mind besteht darin, dass Nutzer, insbesondere Lernende, die Antwort erhalten, ohne den Prozess der Lösungsfindung durchlaufen zu haben. Sie wissen dass etwas so ist (deklaratives Wissen), verstehen aber nicht warum (prozedurales/konzeptionelles Wissen). Dies führt zu einer “Illusion of Knowing” 10: Nutzer überschätzen ihre eigene Kompetenz massiv, weil sie die flüssige Interaktion mit der KI und deren eloquente Ergebnisse mit eigenem Verständnis verwechseln. Eine Studie zeigte, dass 83% der KI-Nutzer sich kurz nach der Erstellung eines Essays nicht mehr an wesentliche Passagen erinnern konnten.7

3.2 Die Souveränitätsfalle (The Sovereignty Trap)

Ein zentraler Aspekt der Hollowed Mind-Theorie ist die “Sovereignty Trap”.9 Sie beschreibt einen psychologischen Mechanismus, bei dem der Nutzer seine intellektuelle Führung (Sovereignty) an die Maschine abtritt. Dies geschieht aus drei Gründen:

- Cognitive Resistance: Der menschliche Drang, Anstrengung zu vermeiden.

- Intellectual Ceding: Die Wahrnehmung der KI als “autoritative Kompetenz”, der man sich unterordnet.

- Motivational Impact: Der Verlust der intrinsischen Belohnung, die normalerweise aus dem Lösen eines schweren Problems resultiert.

Wenn der Weg zur Lösung keine Anstrengung erfordert, fehlt das Dopamin-Signal des Erfolgs. Dies kann langfristig die Lernmotivation untergraben (“Warum soll ich das lernen, wenn die KI es kann?”).

4. Auswirkungen auf Kritisches Denken und Analysefähigkeit

Kritisches Denken ist die Fähigkeit, Informationen zu hinterfragen, Bias zu erkennen und logische Schlüsse zu ziehen. Die empirische Evidenz der Jahre 2024 und 2025 deutet darauf hin, dass unreflektierte KI-Nutzung diese Kernkompetenz gefährdet.

4.1 Die Microsoft-Studie: Vertrauen als Gift für die Kritik

Eine wegweisende Studie von Microsoft Research (Lee et al., 2025) mit 319 Wissensarbeitern und 936 beobachteten Tasks liefert detaillierte Einblicke.11 Die Forscher fanden eine signifikante Korrelation:

- Je höher das Vertrauen in die KI (Confidence in GenAI), desto geringer war die kognitive Anstrengung zur kritischen Prüfung (Critical Thinking Effort).

- Je höher das Selbstvertrauen (Self-Confidence) des Nutzers in die eigene Fachexpertise, desto stärker wurde kritisches Denken aktiviert.

Das bedeutet: KI macht vor allem jene “dümmer” (unkritischer), die der Technologie blind vertrauen oder sich selbst als inkompetent wahrnehmen. Sie fungiert als Verstärker bestehender Dispositionen. Wer unsicher ist, lagert das Denken komplett aus. Wer sicher ist, nutzt KI als Sparringspartner.

4.2 Korrelationen der kognitiven Faulheit

Weitere Studien bestätigen diesen Trend durch quantitative Analysen. Eine Korrelationsmatrix aus einer Studie von 2025 12 zeigt alarmierende Zusammenhänge:

| Variable A | Variable B | Korrelationstyp | Interpretation |

| KI-Tool-Nutzung | Kritisches Denken | Stark Negativ | Häufige Nutzung geht mit sinkender kritischer Analyse einher. |

| KI-Tool-Nutzung | Cognitive Offloading | Stark Positiv | Wer Tools hat, lagert Arbeit massiv aus. |

| Cognitive Offloading | Kritisches Denken | Stark Negativ | Wer Arbeit auslagert, denkt weniger kritisch über das Ergebnis nach. |

Diese Daten suggerieren eine Kausalkette: Die Verfügbarkeit von KI führt zu Offloading, Offloading reduziert die mentale Auseinandersetzung, und mangelnde Auseinandersetzung lässt die kritische Urteilsfähigkeit verkümmern.

4.3 Das Phänomen des Automation Bias

Ein spezifischer Mechanismus, der das kritische Denken unterminiert, ist der Automation Bias. Er beschreibt die Tendenz, automatisierten Empfehlungen mehr zu vertrauen als der eigenen Wahrnehmung oder widersprüchlichen Fakten. Dies ist besonders in Hochrisikobereichen wie der Medizin oder der Luftfahrt dokumentiert, betrifft aber zunehmend den Alltag.

Forschungen aus der Radiologie 13 zeigen zwei Fehlerarten:

- Omission Errors (Unterlassungsfehler): Der Arzt/Nutzer übersieht einen Fehler oder ein Detail, weil die KI es nicht markiert hat. Er verlässt sich darauf, dass die KI “alles sieht”.

- Commission Errors (Kommissionsfehler): Der Arzt/Nutzer folgt einer falschen Empfehlung der KI, obwohl er es eigentlich besser wissen müsste (oder Daten dagegen sprechen).

In der generativen KI ist dies besonders gefährlich, da LLMs zu “Halluzinationen” neigen – plausibel klingenden, aber faktisch falschen Aussagen. Da die Systeme als “Black Box” fungieren (der Entscheidungsweg ist intransparent), fällt die Verifikation schwer.15 Nutzer neigen dazu, die flüssige Sprache und die autoritäre Formulierung der KI mit Wahrheit gleichzusetzen. Eine Studie zur “Automation Bias” in der Programmierung zeigte, dass Entwickler fehlerhaften KI-Code übernahmen, weil die Überprüfung kognitiv anstrengender gewesen wäre als das Neuschreiben.16

5. Metakognition und die Kluft zwischen Novizen und Experten

Ein differenzierter Blick zeigt, dass KI nicht alle Menschen gleichermaßen beeinflusst. Die Auswirkungen hängen stark vom Vorwissen ab.

5.1 Der “Leveler” und der “Amplifier” Effekt

Die Forschung unterscheidet zwei gegensätzliche Wirkungsweisen von KI auf die Kognition 8:

- Der Leveler-Effekt (Der Gleichmacher – für Novizen):

Bei Anfängern hebt KI die Leistung sofort auf ein durchschnittliches Niveau. Ein Student ohne Schreibtalent kann plötzlich passable Essays verfassen; ein Laie kann Code generieren. Das Problem: Die KI fungiert als “externer Hippocampus”. Der Novize erreicht das Ergebnis, ohne die grundlegenden Schemata im Gehirn aufgebaut zu haben. Er bleibt dauerhaft abhängig von der “Krücke”. Wenn die KI wegfällt, fällt die Leistung auf Null. Dies verhindert den Übergang vom Novizen zum Experten. - Der Amplifier-Effekt (Der Verstärker – für Experten):

Experten verfügen bereits über tiefes Domänenwissen (“Neocortical Partner”). Sie können die Ausgabe der KI sofort bewerten, Fehler erkennen und die KI steuern. Für sie wirkt die KI als kognitiver Hebel, der ihre Produktivität und Kreativität massiv steigert. Sie lagern nur die Routine aus, behalten aber die strategische Kontrolle (Sovereignty).

Soziale Implikation: Dies könnte zu einer dramatischen Verschärfung der Bildungskluft führen. Diejenigen, die bereits gebildet sind, werden durch KI noch leistungsfähiger (“Matthäus-Effekt”: Wer hat, dem wird gegeben). Diejenigen, die sich noch in der Ausbildung befinden, laufen Gefahr, den mühsamen Prozess des Kompetenzerwerbs durch KI abzukürzen und somit nie den Expertenstatus zu erreichen, der nötig wäre, um die KI sicher zu beherrschen.

5.2 Metakognitive Defizite

Metakognition ist das “Denken über das Denken” – die Fähigkeit, den eigenen Lernprozess zu überwachen und zu steuern. Studien zeigen, dass KI bei Novizen metakognitive Defizite verstärkt.17 Wer beim Programmierenlernen Copilot nutzt, lernt oft nicht, wie man Fehler sucht (Debugging), weil der Code meist funktioniert. Wenn er nicht funktioniert, fehlt dem Novizen das mentale Modell, um zu verstehen, warum. Er kann sein Vorgehen nicht strategisch anpassen, sondern probiert blind neue Prompts aus (“Trial and Error” statt Verständnis).

Prather et al. (2024) warnen, dass KI die Kluft zwischen guten und schlechten Schülern vergrößert, da leistungsschwache Schüler eher dazu neigen, das Denken komplett an die KI zu delegieren, während leistungsstarke Schüler sie reflektiert nutzen.17

6. Soziale Kognition und emotionale Intelligenz

Die Frage der “Verdummung” beschränkt sich nicht auf logisch-analytische Fähigkeiten. Auch die soziale und emotionale Intelligenz (EQ) ist betroffen.

6.1 Outsourcing von Empathie

In einer Welt, in der KI genutzt wird, um Entschuldigungen, Kondolenzschreiben oder Liebesbriefe zu verfassen, verkümmert die Fähigkeit zur emotionalen Artikulation. Das Ringen um die richtigen Worte ist ein Prozess der emotionalen Verarbeitung. Wenn wir diesen an einen Algorithmus delegieren (“Schreibe eine einfühlsame Nachricht an X”), entkoppeln wir uns von der eigenen Emotion.19

Darüber hinaus fehlt KI-Systemen eine echte Theory of Mind (die Fähigkeit, mentale Zustände anderer zu verstehen). Sie simulieren Empathie nur statistisch. Wer sich in seiner Kommunikation auf diese Simulation verlässt, riskiert, die Nuancen echter menschlicher Interaktion zu verlernen. In Kunden-Service-Kontexten oder der Pflege kann dies zu einer Enthumanisierung führen, wenn KI-Systeme Frustration oder Angst nicht adäquat erkennen.20

6.2 Algorithmische Selbstwahrnehmung

Ein subtiler, aber mächtiger Effekt ist die Veränderung des Selbstbildes durch KI-Feedback. Apps und Wearables, die Stress, Schlaf oder Stimmung analysieren, liefern eine “objektive” Dateninterpretation. Forschung zeigt, dass Menschen dazu neigen, diesen Daten mehr zu glauben als ihrem eigenen Körpergefühl. Wenn eine KI fälschlicherweise Angst oder Stress diagnostiziert, kann dies zu einer Self-fulfilling Prophecy führen: Der Nutzer übernimmt das Label der Maschine und fühlt sich tatsächlich gestresster. Dies schwächt die intrinsische Fähigkeit zur Introspektion und Selbstregulation.19 Wir verlernen, auf uns selbst zu hören, weil wir auf den Algorithmus schauen.

7. Lösungsansätze: AI Literacy und Cognitive Friction

Ein Verbot von KI in Bildung und Arbeit ist angesichts ihrer Ubiquität illusorisch. Die Antwort der Wissenschaft lautet: Qualifizierung und bewusstes Design.

7.1 Frameworks für AI Literacy (KI-Kompetenz)

Organisationen wie Digital Promise und die UNESCO haben 2024/2025 umfassende Kompetenzrahmen entwickelt, um dem kognitiven Kontrollverlust entgegenzuwirken. AI Literacy ist nicht mehr optional, sondern eine Kernkompetenz wie Lesen und Schreiben.22

Das Digital Promise Framework definiert drei Säulen 23:

- Understand (Verstehen):

Nutzer müssen die technischen Grundlagen verstehen: Wie funktionieren Algorithmen? Was sind Trainingsdaten? Warum halluziniert eine KI? Dies entmystifiziert die “Magie” der KI und fördert eine rationale Distanz. Es beinhaltet Computational Thinking (Mustererkennung, Abstraktion). - Use (Nutzen):

Hier wird unterschieden zwischen Interagieren, Erstellen (z.B. Texte generieren) und Anwenden (Probleme lösen). Ziel ist die Befähigung zur Ko-Kreation, bei der der Mensch die Regie führt. - Evaluate (Bewerten):

Dies ist die wichtigste Komponente gegen die “Verdummung”. Sie umfasst:

- Transparenz: Verstehen, woher die Daten kommen.

- Ethik: Erkennen von Bias und Diskriminierung.

- Impact: Die Glaubwürdigkeit prüfen. Nutzer müssen lernen, Fragen zu stellen wie: “Welche Perspektive fehlt in dieser KI-Antwort?” oder “Wem nützt dieser Algorithmus?”

Der UNESCO AI Competency Framework for Students (2024/2025) geht noch weiter und betont “Human Agency” (menschliche Handlungsfähigkeit) und Ethik. Schüler sollen sich nicht nur als Konsumenten, sondern als “AI Co-Creators” und “Ethical Stewards” verstehen.24

7.2 Cognitive Friction als Design-Strategie

Um dem Cognitive Offloading entgegenzuwirken, fordern Forscher die bewusste Implementierung von Cognitive Friction (kognitive Reibung) in Lern- und Arbeitssoftware.26

Das Ziel ist es, das schnelle, intuitive Denken (“System 1” nach Kahneman) zu unterbrechen und das langsame, analytische Denken (“System 2”) zu aktivieren.

Beispiele für Cognitive Friction:

- Keine fertigen Antworten: Eine Lern-KI gibt nicht die Lösung einer Matheaufgabe, sondern stellt eine sokratische Gegenfrage (“Was wäre der erste Schritt?”).

- Unsicherheits-Marker: Die KI markiert Passagen, bei denen sie statistisch unsicher ist, rot, um den Nutzer zur Überprüfung zu zwingen.

- Verpflichtende Reflexion: Bevor ein KI-generierter Text übernommen werden kann, muss der Nutzer in einem Textfeld begründen, warum er diesen Text für korrekt hält.

7.3 Prompting als neue Denkschule

Interessanterweise kann die Arbeit mit KI auch das logische Denken schärfen, wenn sie richtig gelehrt wird. “Prompt Engineering” erfordert hohe kognitive Präzision: Man muss ein Problem dekomponieren (in Teilprobleme zerlegen), Kontext definieren und Ziele klar formulieren. Studien zeigen, dass iteratives Prompting (“Chain-of-Thought”) ähnliche mentale Strukturen fördert wie das Schreiben selbst.28

Der Ansatz lautet: “Prompting ist Denken”. Wer nicht klar denken kann, kann auch nicht gut prompten. In diesem Szenario wird KI nicht zum Ersatz, sondern zum Spiegel der eigenen gedanklichen Klarheit.

8. Synthese und Ausblick: Die Zukunft der menschlichen Intelligenz

Macht KI dumm? Die wissenschaftliche Evidenz der Jahre 2024 und 2025 erlaubt keine einfache Ja/Nein-Antwort, sondern zeichnet ein Bild einer tiefgreifenden kognitiven Transformation.

Ja, KI birgt das Risiko der kognitiven Atrophie:

- Wenn wir integrative Denkprozesse (Synthese, Analyse) vollständig auslagern (Hollowed Mind).

- Wenn wir uns durch Automation Bias in eine passive Abhängigkeit begeben.

- Wenn wir im Bildungsbereich zulassen, dass die “Illusion des Wissens” echte Kompetenz ersetzt.

Nein, KI kann uns kognitiv erweitern:

- Wenn wir sie als Amplifier nutzen, um über unsere biologischen Grenzen hinaus zu denken.

- Wenn wir durch AI Literacy lernen, die “Sovereignty Trap” zu umgehen.

- Wenn wir Reibung (Friction) als notwendigen Teil des Denkprozesses akzeptieren und kultivieren.

Die entscheidende Variable ist nicht die Technologie, sondern die Kognitive Souveränität. Die Gesellschaft steht an einem Scheideweg. Ein Pfad führt in eine Welt, in der eine kleine Elite von Experten KI steuert, während die Masse ihre kognitive Autonomie an Algorithmen abgibt (“Wall-E Szenario” des Geistes). Der andere Pfad führt zu einer symbiotischen Intelligenz, in der KI den Menschen von Routine entlastet, damit dieser sich auf Empathie, Ethik und komplexe Problemlösung konzentrieren kann.

Um den zweiten Pfad zu beschreiten, muss sich unser Bildungssystem radikal wandeln: Weg von der reinen Wissensvermittlung, hin zum Training von Urteilskraft, metakognitiver Steuerung und Widerstandsfähigkeit gegen kognitive Bequemlichkeit. Wir müssen lernen, KI nicht als Orakel zu behandeln, sondern als Werkzeug, das ständige Überwachung und intellektuelle Führung erfordert. Die Gefahr ist nicht, dass die KI zu klug wird, sondern dass wir zu bequem werden, klug zu bleiben.

Bericht Ende

Referenzen

- Effects of generative artificial intelligence on cognitive effort and task performance: study protocol for a randomized controlled experiment among college students – NIH, Zugriff am Januar 6, 2026, https://pmc.ncbi.nlm.nih.gov/articles/PMC12255134/

- Smartphones & Gehirn – die Gefahr der digitalen Demenz | Manfred Spitzer – YouTube, Zugriff am Januar 6, 2026, https://www.youtube.com/watch?v=vgIWipT1h8A

- Demenz wegen digitalen Endgeräten: Hat die Technik den ersten Computer-Nutzern geschadet? – CHIP, Zugriff am Januar 6, 2026, https://www.chip.de/news/gesundheit/demenz-wegen-digitalen-endgeraeten-hat-die-technik-den-ersten-computer-nutzern-geschadet_78706c23-08c1-4ebd-a393-dd2c520b15ce.html

- Extended Mind Hypothesis: Cognition Extending Beyond the Brain – Renascence.io, Zugriff am Januar 6, 2026, https://www.renascence.io/journal/extended-mind-hypothesis-cognition-extending-beyond-the-brain

- KI-gesteuerte Therapie als “Fahrrad für den Verstand – Abby, Zugriff am Januar 6, 2026, https://abby.gg/de/mental-health/ai-driven-therapy-as-a-bicycle-for-the-mind/

- Neural reshaping: the plasticity of human brain and artificial intelligence in the learning process – PMC – PubMed Central, Zugriff am Januar 6, 2026, https://pmc.ncbi.nlm.nih.gov/articles/PMC11751442/

- Generative AI: the risk of cognitive atrophy – Polytechnique Insights, Zugriff am Januar 6, 2026, https://www.polytechnique-insights.com/en/columns/neuroscience/generative-ai-the-risk-of-cognitive-atrophy/

- The extended hollowed mind: why foundational knowledge is indispensable in the age of AI, Zugriff am Januar 6, 2026, https://pmc.ncbi.nlm.nih.gov/articles/PMC12738859/

- The extended hollowed mind: why foundational … – Frontiers, Zugriff am Januar 6, 2026, https://www.frontiersin.org/journals/artificial-intelligence/articles/10.3389/frai.2025.1719019/full

- The impact of generative AI on critical thinking skills: a systematic review, conceptual framework and future research directions – Emerald Publishing, Zugriff am Januar 6, 2026, https://www.emerald.com/idd/article/doi/10.1108/IDD-05-2025-0125/1271372/The-impact-of-generative-AI-on-critical-thinking

- The Impact of Generative AI on Critical Thinking: Self … – Microsoft, Zugriff am Januar 6, 2026, https://www.microsoft.com/en-us/research/wp-content/uploads/2025/01/lee_2025_ai_critical_thinking_survey.pdf

- AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking, Zugriff am Januar 6, 2026, https://www.mdpi.com/2075-4698/15/1/6

- Bias recognition and mitigation strategies in artificial intelligence healthcare applications – PMC – PubMed Central, Zugriff am Januar 6, 2026, https://pmc.ncbi.nlm.nih.gov/articles/PMC11897215/

- Automation Bias in Mammography: The Impact of Artificial Intelligence BI-RADS Suggestions on Reader PerformanceRadiology – RSNA Journals, Zugriff am Januar 6, 2026, https://pubs.rsna.org/doi/abs/10.1148/radiol.222176

- ChatGPT in Medical Education: A Precursor for Automation Bias?, Zugriff am Januar 6, 2026, https://mededu.jmir.org/2024/1/e50174/

- AI Safety and Automation Bias | Center for Security and Emerging Technology, Zugriff am Januar 6, 2026, https://cset.georgetown.edu/publication/ai-safety-and-automation-bias/

- Protecting Human Cognition in the Age of AI – arXiv, Zugriff am Januar 6, 2026, https://arxiv.org/html/2502.12447v3

- KÜNSTLICHE INTELLIGENZ IN DER SCHULE: CHANCEN NUTZEN, HERAUSFORDERUNGEN MEISTERN, Zugriff am Januar 6, 2026, https://www.lch.ch/fileadmin/user_upload_lch/Politik/Positionspapiere/240429_Positionspapier_KI_in_der__Schule_Vollversion.pdf

- Cognitive offloading or cognitive overload? How AI alters the mental architecture of coping, Zugriff am Januar 6, 2026, https://pmc.ncbi.nlm.nih.gov/articles/PMC12678390/

- (PDF) Matta 2025 AI Theory of Mind – ResearchGate, Zugriff am Januar 6, 2026, https://www.researchgate.net/publication/396424108_Matta_2025_AI_Theory_of_Mind

- Cognitive offloading or cognitive overload? How AI alters the mental architecture of coping, Zugriff am Januar 6, 2026, https://www.frontiersin.org/journals/psychology/articles/10.3389/fpsyg.2025.1699320/full

- Why AI literacy is now a core competency in education | World Economic Forum, Zugriff am Januar 6, 2026, https://www.weforum.org/stories/2025/05/why-ai-literacy-is-now-a-core-competency-in-education/

- Revealing an AI Literacy Framework for Learners and Educators …, Zugriff am Januar 6, 2026, https://digitalpromise.org/2024/02/21/revealing-an-ai-literacy-framework-for-learners-and-educators/

- UNESCO AI competency framework for students – Cedefop – European Union, Zugriff am Januar 6, 2026, https://www.cedefop.europa.eu/en/tools/vet-toolkit-tackling-early-leaving/resources/unesco-ai-competency-framework-students

- AI competency framework for students – UNESCO, Zugriff am Januar 6, 2026, https://www.unesco.org/en/articles/ai-competency-framework-students

- The Importance of Friction in AI Systems – Mozilla Foundation, Zugriff am Januar 6, 2026, https://www.mozillafoundation.org/en/blog/the-importance-of-friction-in-ai-systems/

- Rethinking Cognitive Friction: The Answer to AI Overreliance – UXmatters, Zugriff am Januar 6, 2026, https://www.uxmatters.com/mt/archives/2024/12/rethinking-cognitive-friction-the-answer-to-ai-overreliance.php

- Gutes Prompten = gutes Denken – Dr. Josef Sawetz, Zugriff am Januar 6, 2026, https://www.sawetz.com/publications/Sawetz_Gutes_Prompten_ist_gutes_Denken_2025.pdf

KI-gestützt. Menschlich veredelt.

Martin Käßler ist ein erfahrener Tech-Experte im Bereich AI, Technologie, Energie & Space mit über 15 Jahren Branchenerfahrung. Seine Artikel verbinden fundiertes Fachwissen mit modernster KI-gestützter Recherche- und Produktion. Jeder Beitrag wird von ihm persönlich kuratiert, faktengeprüft und redaktionell verfeinert, um höchste inhaltliche Qualität und maximalen Mehrwert zu garantieren.

Auch bei sorgfältigster Prüfung sehen vier Augen mehr als zwei. Wenn Ihnen ein Patzer aufgefallen ist, der uns entgangen ist, lassen Sie es uns bitte wissen: Unser Postfach ist martinkaessler, gefolgt von einem @ und dem Namen einer bekannten Suchmaschine (also googlemail) mit der Endung .com. Oder besuchen Sie Ihn gerne einfach & direkt auf LinkedIn.