LMarena im Fokus: Eine Tiefenanalyse der Methodik, des Rankings und der Kontroversen der führenden LLM-Benchmark-Plattform

Einleitung: Die Notwendigkeit einer dynamischen KI-Bewertung

Die rapide Entwicklung von Large Language Models (LLMs) hat die Landschaft der künstlichen Intelligenz grundlegend verändert. Mit dieser Entwicklung geht jedoch eine zentrale Herausforderung einher: die adäquate Bewertung ihrer Fähigkeiten. Traditionelle, automatisierte Metriken wie Perplexität oder BLEU-Scores, die einst zur Messung der Sprachqualität dienten, erweisen sich als unzureichend. Sie erfassen lediglich oberflächliche Aspekte und scheitern an der Bewertung von entscheidenden, menschenähnlichen Qualitäten wie Kohärenz, logischem Denken, Kreativität und der Ausrichtung an menschlichen Werten.1

Gleichzeitig leiden statische Benchmarks wie GLUE oder SuperGLUE, die lange als Industriestandard galten, zunehmend unter dem Problem der „Kontamination“. Dabei gelangen Testdaten unbeabsichtigt in die riesigen Trainingsdatensätze der Modelle, was zu künstlich überhöhten Leistungswerten führt und die Zuverlässigkeit der Ergebnisse untergräbt.4 Zudem spiegeln ihre oft geschlossenen Frage-Antwort-Formate die reale, interaktive und offene Natur von Chatbot-Anwendungen nur unzureichend wider.5

In diese Lücke stößt LMarena (auch bekannt als Chatbot Arena), eine von der Forschungsgruppe Large Model Systems Organization (LMSYS) entwickelte Crowdsourcing-Plattform. Sie stellt einen Paradigmenwechsel in der KI-Evaluation dar, indem sie den Fokus von maschinellen Metriken auf menschliche Präferenzen verlagert.4 Durch direkte, anonymisierte Paarvergleiche, bei denen Tausende von Nutzern entscheiden, welche von zwei Modellantworten besser ist, entsteht eine dynamische und realitätsnahe Rangliste.7 Die Entstehung von LMarena ist somit keine isolierte technische Innovation, sondern eine direkte und notwendige Konsequenz aus dem Versagen etablierter Evaluationsmethoden, mit der Komplexität moderner generativer KI Schritt zu halten. Die Plattform verkörpert einen fundamentalen Wandel in der Philosophie der KI-Bewertung: weg von der Frage „Ist die Antwort technisch korrekt?“ hin zur entscheidenden Frage „Welche Antwort bevorzugt ein Mensch?“.

Dieser Bericht bietet eine tiefgehende Analyse von LMarena. Er beleuchtet nicht nur die detaillierte Funktionsweise der Plattform und ihres Ranking-Systems, sondern präsentiert auch die aktuellen Ranglisten. Darüber hinaus wird eine fundierte kritische Auseinandersetzung mit den methodischen Grenzen und den jüngsten Kontroversen vorgenommen, die die Objektivität und Fairness der Arena in Frage stellen.

1. Das LMarena-Paradigma: Jenseits statischer Benchmarks

Die Etablierung von LMarena als führende Benchmark-Plattform lässt sich nur im Kontext der signifikanten Schwächen traditioneller Evaluationsmethoden verstehen.

Die Grenzen traditioneller Benchmarks

Statische Benchmarks sind aus zwei Hauptgründen an ihre Grenzen gestoßen. Erstens, das Problem der Kontamination und Sättigung: Da die Testdatensätze öffentlich und unveränderlich sind, besteht eine hohe Wahrscheinlichkeit, dass sie Teil der gigantischen, aus dem Internet zusammengetragenen Trainingsdaten neuerer Modelle werden. Dies führt dazu, dass Modelle die Antworten auf Testfragen „auswendig lernen“, anstatt ihre tatsächliche Generalisierungs- und Schlussfolgerungsfähigkeit unter Beweis zu stellen. Die Benchmarks werden „gesättigt“, und die Scores verlieren ihre Aussagekraft über die wahre Leistungsfähigkeit.4 Zweitens, der Mangel an Realitätsnähe: Akademische Benchmarks basieren oft auf Aufgaben mit einer einzigen, klar definierten richtigen Antwort. Die wahre Stärke moderner LLMs liegt jedoch in ihrer Fähigkeit, offene, kreative, nuancierte und dialogische Aufgaben zu bewältigen, für die es keine singuläre „richtige“ Antwort gibt.4

Der Wert der menschlichen Evaluation

Menschliche Bewerter sind in der Lage, subtile Aspekte zu erfassen, die für automatisierte Metriken unsichtbar bleiben. Dazu gehören der Tonfall einer Antwort, ihre kontextuelle Angemessenheit, emotionale Intelligenz, stilistische Eleganz sowie die logische Kohärenz und der argumentative Fluss.2 In einer Welt, in der LLMs zunehmend für kreative und kollaborative Aufgaben eingesetzt werden, wird die subjektive Nutzerpräferenz zum ultimativen Maßstab für die Qualität und Nützlichkeit eines KI-Systems. LMarena operationalisiert diesen „Goldstandard“ der menschlichen Bewertung in einem bisher unerreichten Maßstab.2

“In-the-Wild”-Datenerhebung

Ein entscheidender Vorteil von LMarena ist die Methode der Datenerhebung. Anstatt auf einem festen, kuratierten Satz von Fragen zu basieren, sammelt die Plattform kontinuierlich neue und vielfältige Anfragen („Prompts“) von einer breiten globalen Nutzerbasis.1 Diese „In-the-Wild“-Prompts spiegeln die tatsächliche Nutzung von LLMs wider – von einfachen Wissensabfragen über komplexe Programmierprobleme bis hin zu kreativen Schreibaufträgen. Dieser dynamische und stetig wachsende Datensatz verhindert nicht nur die Kontamination, sondern sorgt auch dafür, dass die Bewertung relevant bleibt und sich mit den sich ändernden Anwendungsfällen von LLMs weiterentwickelt.4

Dabei ist LMarena mehr als nur ein Evaluierungswerkzeug; es fungiert als ein massives, kontinuierliches Datenerfassungsprojekt für menschliche Präferenzen. Die Plattform hat bereits über 5 Millionen Nutzerabstimmungen gesammelt, die jeweils aus einem Tripel von (Prompt, Antwort A, Antwort B) und der dazugehörigen menschlichen Präferenz bestehen.11 Dieses Datenformat ist exakt das, was für das Reinforcement Learning from Human Feedback (RLHF) benötigt wird – eine Kerntechnologie, die zur Feinabstimmung und Ausrichtung von LLMs auf menschliche Werte und Erwartungen eingesetzt wird. Obwohl LMSYS die Konversationshistorien aus Datenschutzgründen nicht veröffentlicht 5, kuratiert die Organisation hinter der Arena somit einen der wertvollsten Datensätze der Welt für das Training zukünftiger KI-Generationen. Dies verleiht der Plattform eine strategische Bedeutung, die weit über ihre öffentliche Funktion als reine Rangliste hinausgeht.

2. Die Funktionsweise der Arena: Vom direkten Vergleich zur globalen Rangliste

Die Effektivität von LMarena beruht auf einem einfachen, aber robusten Prozess, der auf den Prinzipien des Crowdsourcing, der Anonymisierung und des direkten Vergleichs basiert.

Der “Battle”-Prozess aus Nutzersicht

Der Kern der Plattform ist der sogenannte „Battle“-Modus. Ein Nutzer gibt eine beliebige Anfrage ein und erhält daraufhin zwei Antworten von zwei unterschiedlichen, aber für den Nutzer anonymisierten LLMs, die nebeneinander angezeigt werden.5 Nach dem Vergleich der beiden Antworten stimmt der Nutzer für das Modell, das die bessere Antwort geliefert hat, oder deklariert ein Unentschieden. Erst nach der Stimmabgabe werden die Namen der beiden konkurrierenden Modelle aufgedeckt.4 Dieser „blinde“ Testaufbau ist von entscheidender Bedeutung, da er eine Voreingenommenheit (Bias) der Nutzer gegenüber bekannten und etablierten Modellnamen wie GPT-4 oder Claude verhindert und eine rein leistungsbasierte Bewertung sicherstellt.8

Crowdsourcing als Motor

LMarena ist eine offene und frei zugängliche Plattform, die Forscher, Entwickler und die breite Öffentlichkeit zur Teilnahme einlädt.4 Dieser Ansatz ermöglicht die Sammlung einer enormen Menge an Abstimmungen von einer heterogenen und globalen Nutzergruppe. Bis April 2024 wurden bereits über 800.000 Paarvergleiche gesammelt; diese Zahl ist inzwischen auf über 5 Millionen angewachsen.11 Dieses hohe Volumen an Datenpunkten schafft eine statistisch robuste Grundlage, die es ermöglicht, zuverlässige und aussagekräftige Ranglisten zu erstellen.

Die Architektur der Plattform

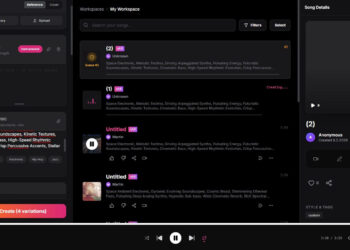

Die Plattform wird von einem Konsortium aus Forschern der UC Berkeley, UC San Diego und der Carnegie Mellon University betrieben.11 Um eine differenzierte Bewertung der vielfältigen Fähigkeiten moderner KI-Modelle zu ermöglichen, bietet LMarena verschiedene spezialisierte „Arenen“. Neben der allgemeinen Text-Arena gibt es dedizierte Wettbewerbe für Bereiche wie Programmierung (WebDev), Bilderkennung (Vision), Text-zu-Bild-Generierung und weitere, was eine granulare Analyse der Stärken und Schwächen einzelner Modelle erlaubt.13

Das Design der Arena nutzt dabei geschickt psychologische Prinzipien, um die Nutzerbeteiligung zu maximieren. Die Bezeichnung als „Battle“ und der kompetitive Charakter gamifizieren den sonst trockenen Prozess der Evaluation. Die Anonymisierung der Modelle erzeugt Neugier und Spannung: Der Nutzer fragt sich unweigerlich, welches Modell hinter einer besonders guten oder schlechten Antwort steckt. Die sofortige Enthüllung der Modellnamen nach der Abstimmung befriedigt diese Neugier und schließt eine kognitive Schleife, was als unmittelbare Belohnung wirkt und einen Lerneffekt für den Nutzer erzeugt. Diese Kombination aus Gamification und sofortigem Feedback, bekannt aus dem User-Experience-Design, ist ein entscheidender, aber oft übersehener Faktor für den Erfolg und die Skalierbarkeit der Plattform.

3. Das Herzstück des Rankings: Das Elo-System und das Bradley-Terry-Modell

Um aus Millionen von einzelnen Paarvergleichen eine konsistente und globale Rangliste zu erstellen, greift LMarena auf ein bewährtes statistisches System zurück, das seinen Ursprung im Schach hat: das Elo-System.

Einführung in das Elo-System

Das Elo-System wurde entwickelt, um die relative Spielstärke von Schachspielern zu messen.14 Sein Kernprinzip ist, dass die Veränderung der Punktzahl nach einem Match nicht nur vom Ergebnis (Sieg, Niederlage, Unentschieden) abhängt, sondern auch von der erwarteten Siegeswahrscheinlichkeit. Diese Erwartung wird aus der Differenz der Elo-Werte der beiden Kontrahenten vor dem Match berechnet. Ein Sieg gegen einen deutlich stärker eingestuften Gegner führt zu einem größeren Punktgewinn als ein erwarteter Sieg gegen einen schwächeren Gegner. Dieses Prinzip lässt sich direkt auf den Vergleich von LLMs übertragen, wobei jedes Modell als „Spieler“ betrachtet wird.5

Mathematische Grundlagen und Adaption für LLMs

Die erwartete Siegeswahrscheinlichkeit () für Modell A gegen Modell B wird über eine logistische Funktion berechnet. Die von LMarena verwendete Formel lautet:

Hierbei sind und die aktuellen Elo-Werte der Modelle A und B. Die Konstanten (Basis 10 und Skalierungsfaktor 400) sind Konventionen aus dem Schach, die sicherstellen, dass eine Elo-Differenz von 400 Punkten einer erwarteten Siegesquote von etwa 10:1 entspricht.16

Nach jedem „Battle“ wird der Elo-Wert eines Modells anhand der folgenden Formel aktualisiert:

Dabei ist der neue Elo-Wert, der alte Wert, das tatsächliche Ergebnis (1 für einen Sieg, 0.5 für ein Unentschieden, 0 für eine Niederlage) und der sogenannte K-Faktor.5

Der K-Faktor

Der K-Faktor ist ein entscheidender Parameter, der die maximale Punktveränderung pro Spiel und damit die „Volatilität“ oder Reaktionsgeschwindigkeit der Rangliste bestimmt.15 Während im Schach oft ein K-Faktor von 32 oder höher verwendet wird, um schnellen Leistungsänderungen von Spielern Rechnung zu tragen, nutzt LMarena einen sehr niedrigen Wert von .16 Diese bewusste methodische Entscheidung zielt darauf ab, die Rangliste stabiler zu machen und eine übermäßige Beeinflussung durch wenige, zufällige oder aktuelle Ergebnisse zu verhindern. Es stellt einen Kompromiss dar: Die Stabilität schützt die Rangliste vor kurzfristigen Schwankungen und statistischem Rauschen, macht sie aber gleichzeitig träger gegenüber echten Leistungsverbesserungen neuer Modelle. Für neue Herausforderer bedeutet dies, dass sie eine sehr große Anzahl konsistenter Siege gegen etablierte Modelle erzielen müssen, um in der Rangliste signifikant aufzusteigen, was etablierte, hoch bewertete Modelle tendenziell bevorteilt.

Verbindung zum Bradley-Terry-Modell

Aus statistischer Sicht ist das Elo-System eng mit dem Bradley-Terry-Modell verwandt.11 Dieses Modell wird verwendet, um aus einer Reihe von Paarvergleichen eine latente „Stärke“ für jeden Teilnehmer abzuleiten. Das Elo-System kann als eine effiziente, iterative Methode zur Schätzung der Stärkeparameter (der sogenannten BT-Koeffizienten) dieses Modells verstanden werden.4 Die Elo-Werte in der LMarena-Rangliste sind also eine Annäherung an die im Bradley-Terry-Modell definierten, zugrundeliegenden Stärken der LLMs.

4. Die LMarena-Rangliste: Eine detaillierte Analyse der Spitzenmodelle

Die resultierende Rangliste von LMarena ist zu einem der meistzitierten Indikatoren für die Leistungsfähigkeit von LLMs geworden. Die folgende Tabelle zeigt die Spitzenpositionen der allgemeinen „Text“-Arena, basierend auf den am 8. Oktober 2025 verfügbaren Daten.

Tabelle 1: Top 15 LLMs der LMarena “Text”-Rangliste (Stand: 8. Oktober 2025)

| Rang | Modellname | Elo-Wert | 95% Konfidenzintervall (±) | Anzahl der Stimmen | Entwickler/Organisation |

| 1 | gemini-2.5-pro | 1452 | 4 | 52,621 | |

| 1 | claude-sonnet-4-5-20250929-thinking-32k | 1448 | 9 | 4,415 | Anthropic |

| 1 | claude-opus-4-1-20250805-thinking-16k | 1448 | 5 | 19,933 | Anthropic |

| 2 | chatgpt-4o-latest-20250326 | 1441 | 4 | 37,775 | OpenAI |

| 2 | gpt-4.5-preview-2025-02-27 | 1441 | 6 | 14,644 | OpenAI |

| 2 | gpt-5-high | 1440 | 6 | 21,844 | OpenAI |

| 2 | o3-2025-04-16 | 1440 | 4 | 50,195 | OpenAI |

| 2 | claude-opus-4-1-20250805 | 1438 | 5 | 31,452 | Anthropic |

| 2 | claude-sonnet-4-5-20250929 | 1437 | 9 | 4,116 | Anthropic |

| 3 | qwen3-max-preview | 1434 | 6 | 16,788 | Alibaba |

| 8 | qwen3-max-2025-09-23 | 1425 | 8 | 5,484 | Alibaba |

| 9 | gpt-5-chat | 1426 | 5 | 20,244 | OpenAI |

| 9 | glm-4.6 | 1421 | 11 | 3,056 | Z.ai |

| 9 | grok-4-fast | 1420 | 8 | 6,139 | xAI |

| 9 | deepseek-v3.2-exp-thinking | 1418 | 11 | 3,017 | DeepSeek AI |

Quelle: LMarena Leaderboard, extrahiert aus.13

Anleitung zur Interpretation

Eine korrekte Interpretation dieser Daten erfordert die Berücksichtigung mehrerer Faktoren:

- Elo-Werte sind relativ, nicht absolut: Ein Elo-Wert ist keine absolute Maßeinheit für „Intelligenz“. Er beschreibt die relative Stärke eines Modells im Vergleich zu den anderen Modellen im Pool. Die Differenz ist entscheidend: Eine Elo-Differenz von 200 Punkten zwischen zwei Modellen bedeutet, dass das höher bewertete Modell in einem direkten Vergleich voraussichtlich etwa 76% der Duelle gewinnen wird.14

- Die Bedeutung des Konfidenzintervalls (CI): Das 95%-Konfidenzintervall gibt den statistischen Unsicherheitsbereich des berechneten Elo-Wertes an. Ein kleines CI (z.B. ±4 bei gemini-2.5-pro) deutet auf eine hohe statistische Sicherheit des Rankings hin, die durch eine große Anzahl von Stimmen gestützt wird. Ein größeres CI (z.B. ±11 bei glm-4.6) bedeutet, dass der „wahre“ Elo-Wert mit 95%iger Wahrscheinlichkeit in einem breiteren Bereich liegt. Modelle, deren Konfidenzintervalle sich überlappen, sollten als leistungsmäßig sehr ähnlich oder statistisch ununterscheidbar betrachtet werden.11

- Die Rolle der Stimmenanzahl: Die Anzahl der Stimmen ist ein Indikator für die Robustheit und Zuverlässigkeit des Elo-Wertes. Ein Modell mit Zehntausenden von Stimmen hat einen sehr stabilen und verlässlichen Rang. Die Bewertungen von Modellen mit nur wenigen hundert oder tausend Stimmen sind hingegen als vorläufig zu betrachten und können sich noch deutlich ändern.15

5. Kritische Perspektiven: Die Grenzen und Schwachstellen der Arena

Trotz ihres innovativen Ansatzes ist die LMarena nicht frei von methodischen Schwächen und systemischen Verzerrungen. In jüngster Zeit sind zudem ernsthafte Kontroversen über die Fairness und Transparenz der Plattform aufgekommen, die ihre Glaubwürdigkeit als objektiver Maßstab in Frage stellen.

5.1 Systemische Verzerrungen (Selection Bias)

Die Zusammensetzung der Nutzer und die Art der gestellten Anfragen führen zu Verzerrungen in den Ergebnissen. Die Nutzerdemografie ist wahrscheinlich stark auf technikaffine Personen, Forscher und Entwickler ausgerichtet und nicht repräsentativ für die Allgemeinbevölkerung. Deren Präferenzen, beispielsweise für präzise Code-Generierung oder detaillierte technische Erklärungen, könnten Modelle, die in diesen Bereichen stark sind, überproportional bevorteilen.17

Darüber hinaus begünstigt das User Interface der Arena kurze, in sich geschlossene Prompts, die dem typischen „ChatGPT-Anwendungsfall“ von 2023 entsprechen. Komplexe Aufgaben, die lange Kontexte, das Hochladen und Analysieren von Dokumenten oder tiefgreifende, mehrstufige logische Schlussfolgerungen erfordern, werden systematisch unterrepräsentiert. Die Rangliste spiegelt daher möglicherweise nur unzureichend die Leistung bei anspruchsvollen, professionellen Anwendungsfällen wider.9

5.2 Anreize und unbeabsichtigte Folgen

Das Bewertungssystem schafft Anreize für Verhaltensweisen, die zwar zu höheren Bewertungen führen, aber nicht unbedingt die Qualität des Modells verbessern. Ein solches Verhalten ist das „User Pandering“: Modelle könnten darauf optimiert werden, übermäßig höfliche, schmeichelhafte oder den Nutzer bestätigende Antworten zu geben (Sycophancy), da dies die subjektive Wahrnehmung und damit die Wahrscheinlichkeit einer positiven Bewertung erhöht, selbst wenn der sachliche Gehalt der Antwort mittelmäßig ist.9

Ein weiteres Problem ist die Bestrafung von Sicherheit. Modelle, die durch Reinforcement Learning from Human Feedback (RLHF) darauf trainiert wurden, potenziell schädliche, grenzwertige oder unangemessene Anfragen abzulehnen, werden von Nutzern, die eine Antwort erwarten, möglicherweise negativ bewertet. Dies kann Modellen, die weniger strenge Sicherheitsfilter haben, einen unfairen Vorteil verschaffen.9

5.3 Kontroversen um Fairness und Transparenz (“The Leaderboard Illusion”)

Ein im April 2025 veröffentlichtes Forschungspapier mit dem Titel „The Leaderboard Illusion“ hat schwerwiegende Vorwürfe gegen die Praktiken der LMarena erhoben und eine intensive Debatte über ihre Fairness ausgelöst.18 Die zentralen Kritikpunkte sind:

- Undisclosed Private Testing und Cherry-Picking: Es gibt starke Belege dafür, dass große kommerzielle Anbieter wie Meta, Google und OpenAI die Möglichkeit haben, zahlreiche Modellvarianten privat und anonym in der Arena zu testen. Anschließend können sie selektiv nur die Variante mit dem höchsten Score offiziell veröffentlichen und die Ergebnisse der schlechter abschneidenden Varianten zurückziehen. Als extremes Beispiel wird Meta genannt, das im Vorfeld des Llama-4-Releases 27 verschiedene Varianten getestet haben soll. Diese Praxis des „Cherry-Picking“ verwandelt die Evaluation in ein gezieltes „Optimieren auf den Benchmark“ und verzerrt das Bild der tatsächlichen Entwicklungsfortschritte.18

- Unfaire Auswahlraten (Sampling Rates): Kritiker bemängeln, dass die Modelle proprietärer Anbieter in einer signifikant höheren Anzahl von „Battles“ zufällig ausgewählt werden als Open-Weight-Modelle. Dies gibt ihnen mehr Gelegenheiten, ihren Elo-Score zu verbessern und zu stabilisieren, während weniger häufig gezeigte Modelle benachteiligt werden.18

- Stillschweigende Entfernung (Deprecation): Es wurde aufgedeckt, dass ein Großteil der öffentlichen Modelle (205 von 243) im Laufe der Zeit stillschweigend aus der Arena entfernt wurde. Diese Praxis betrifft überproportional Open-Source-Modelle und erschwert die langfristige Vergleichbarkeit und Nachvollziehbarkeit der Rangliste.18

Diese aufgedeckten Probleme haben tiefgreifende Implikationen. Sie transformieren LMarena von einem potenziell neutralen wissenschaftlichen Instrument zu einem strategischen Feld, auf dem der Wettbewerb der großen KI-Labore ausgetragen wird. Wenn die Ranglistenposition nicht mehr nur die reine Modellqualität widerspiegelt, sondern auch die Fähigkeit eines Unternehmens, die Regeln und die Infrastruktur der Arena strategisch für sich zu nutzen, wird die grundlegende Glaubwürdigkeit der Plattform als objektiver Schiedsrichter untergraben. Die Community könnte fälschlicherweise annehmen, ein proprietäres Modell sei überlegen, obwohl es in Wirklichkeit nur effektiver getestet und selektiert wurde, was die Wahrnehmung des KI-Fortschritts und die Akzeptanz von Open-Source-Alternativen negativ beeinflussen kann.

6. Fazit und Ausblick: Die Rolle von LMarena in der Zukunft der KI-Evaluation

LMarena hat die Evaluation von Large Language Models unbestreitbar revolutioniert. Durch die konsequente Fokussierung auf menschliche Präferenzen und den Einsatz eines dynamischen Crowdsourcing-Ansatzes hat die Plattform einen neuen Standard gesetzt und die Unzulänglichkeiten traditioneller, statischer Benchmarks offengelegt. Sie liefert wertvolle, realitätsnahe Daten über die subjektive Nutzerzufriedenheit, die für Entwickler und Anwender von unschätzbarem Wert sind.

Gleichzeitig haben die jüngsten Enthüllungen über systemische Verzerrungen und unfaire Praktiken wie privates Testen und selektive Veröffentlichung die Integrität und Objektivität der Rangliste ernsthaft in Frage gestellt. Die Arena ist nicht der neutrale Schiedsrichter, für den sie viele gehalten haben, sondern ein komplexes soziotechnisches System mit eigenen Anreizstrukturen und Schwachstellen, die von ressourcenstarken Akteuren ausgenutzt werden können.

Aus dieser Analyse ergeben sich klare Empfehlungen für die Praxis:

- Die Arena-Rangliste sollte als ein wichtiger Datenpunkt, aber niemals als die alleinige Wahrheit betrachtet werden. Sie gibt einen guten Überblick über die allgemeine „Beliebtheit“ und dialogische Finesse eines Modells, ist aber kein verlässlicher Indikator für die Leistung bei spezialisierten oder komplexen Aufgaben.9

- Organisationen müssen eigene, anwendungsspezifische Evaluations-Sets („evals“) entwickeln. Der entscheidende Maßstab für die Auswahl eines Modells ist seine Leistung im konkreten Anwendungsfall. Dies erfordert die Erstellung maßgeschneiderter Testdatensätze und Bewertungsrubriken, die die spezifischen Anforderungen des eigenen Projekts widerspiegeln.3

Für die Zukunft der KI-Evaluation zeichnet sich ein hybrider Ansatz ab. Öffentliche, breit angelegte Benchmarks wie LMarena werden weiterhin eine wichtige Rolle für den allgemeinen Vergleich spielen, müssen aber dringend ihre Transparenz bezüglich ihrer Test- und Auswahlrichtlinien erhöhen, um ihre Glaubwürdigkeit wiederherzustellen.18 Parallel dazu könnten alternative Ranking-Systeme an Bedeutung gewinnen, die auf anderen Datenquellen basieren, wie etwa die OpenRouterAI-Rangliste, die auf der realen, kostenbasierten API-Nutzung beruht.18 Letztendlich wird ein ganzheitliches Bild der Modellfähigkeiten nur durch die Kombination dieser öffentlichen Benchmarks mit rigorosen, privaten und anwendungsspezifischen Tests zu erreichen sein.

Referenzen

- Which LLM is better – Chabot Arena – DeepNatural Blog, Zugriff am Oktober 14, 2025, https://deepnatural.ai/blog/which-llm-is-better-chabot-arena-en

- LLM Evaluation: Metrics, Benchmarks & Best Practices – Codecademy, Zugriff am Oktober 14, 2025, https://www.codecademy.com/article/llm-evaluation-metrics-benchmarks-best-practices

- LLM benchmarks, evals and tests: A mental model | Thoughtworks United States, Zugriff am Oktober 14, 2025, https://www.thoughtworks.com/en-us/insights/blog/generative-ai/LLM-benchmarks,-evals,-and-tests

- Chatbot Arena: An Open Platform for Evaluating LLMs by … – arXiv, Zugriff am Oktober 14, 2025, https://arxiv.org/pdf/2403.04132

- Chatbot Arena: Benchmarking LLMs in the Wild with Elo Ratings | LMSYS Org, Zugriff am Oktober 14, 2025, https://lmsys.org/blog/2023-05-03-arena/

- How Does Chatbot Arena Work? A Complete Guide – BytePlus, Zugriff am Oktober 14, 2025, https://www.byteplus.com/en/topic/416701

- Chatbot Arena: An Open Platform for Evaluating LLMs by Human Preference – arXiv, Zugriff am Oktober 14, 2025, https://arxiv.org/html/2403.04132v1

- Chatbot Arena Human Preference Predictions: tech review – Nebius, Zugriff am Oktober 14, 2025, https://nebius.com/blog/posts/chatbot-arena-competition-review

- How much should we read into LLM Chatbot Arena leaderboard …, Zugriff am Oktober 14, 2025, https://ashutoshmehra.net/blog/2024/06/llm-chatbot-arena-limitations/

- Why Benchmarks Matter for Evaluating LLMs (and Why Most Miss the Mark) | Label Studio, Zugriff am Oktober 14, 2025, https://labelstud.io/blog/why-benchmarks-matter-for-evaluating-llms/

- From GPT-4 to Llama 3: LMSYS Chatbot Arena Ranks Top LLMs – Analytics Vidhya, Zugriff am Oktober 14, 2025, https://www.analyticsvidhya.com/blog/2024/05/from-gpt-4-to-llama-3-lmsys-chatbot-arena-ranks-top-llms/

- Chatbot Arena + – OpenLM.ai, Zugriff am Oktober 14, 2025, https://openlm.ai/chatbot-arena/

- Overview Leaderboard | LMArena, Zugriff am Oktober 14, 2025, https://lmarena.ai/leaderboard

- Elo rating system – Wikipedia, Zugriff am Oktober 14, 2025, https://en.wikipedia.org/wiki/Elo_rating_system

- How to Read Elo Ratings and Arena Scores for LLMs – Statology, Zugriff am Oktober 14, 2025, https://www.statology.org/how-to-read-elo-ratings-and-arena-scores-for-llms/

- Chatbot Arena and the Elo rating system – Part 1 – Yi Zhu, Zugriff am Oktober 14, 2025, https://bryanyzhu.github.io/posts/2024-06-20-elo-part1/

- Unpopular opinion. The chatbot arena benchmark is not useless, rather it is misunderstood. It is not necessarily an hard benchmark, rather it is a benchmark of “what if the LLM would answer common queries for search engines”? : r/LocalLLaMA – Reddit, Zugriff am Oktober 14, 2025, https://www.reddit.com/r/LocalLLaMA/comments/1ij4c7h/unpopular_opinion_the_chatbot_arena_benchmark_is/

- Understanding the recent criticism of the Chatbot Arena, Zugriff am Oktober 14, 2025, https://simonwillison.net/2025/Apr/30/criticism-of-the-chatbot-arena/

KI-gestützt. Menschlich veredelt.

Martin Käßler ist ein erfahrener Tech-Experte im Bereich AI, Technologie, Energie & Space mit über 15 Jahren Branchenerfahrung. Seine Artikel verbinden fundiertes Fachwissen mit modernster KI-gestützter Recherche- und Produktion. Jeder Beitrag wird von ihm persönlich kuratiert, faktengeprüft und redaktionell verfeinert, um höchste inhaltliche Qualität und maximalen Mehrwert zu garantieren.

Auch bei sorgfältigster Prüfung sehen vier Augen mehr als zwei. Wenn Ihnen ein Patzer aufgefallen ist, der uns entgangen ist, lassen Sie es uns bitte wissen: Unser Postfach ist martinkaessler, gefolgt von einem @ und dem Namen einer bekannten Suchmaschine (also googlemail) mit der Endung .com. Oder besuchen Sie Ihn gerne einfach & direkt auf LinkedIn.