ACE-Step 1.5: Die Architektur der klanglichen Freiheit: Ein umfassendes Dossier zum KI-Musikgenerator ACE-Step 1.5

Die Veröffentlichung von ACE-Step 1.5 am 3. Februar 2026 markiert eine neue Ära in der Geschichte der generativen Künstlichen Intelligenz, der in Fachkreisen oft als der „Stable Diffusion Moment“ für die Musikindustrie bezeichnet wird.1 Während die vorangegangenen Jahre durch die Dominanz proprietärer Cloud-Plattformen geprägt waren, die den schöpferischen Prozess hinter Paywalls und geschlossenen Ökosystemen isolierten, etabliert ACE-Step 1.5 ein neues Paradigma der lokalen, hochperformanten Audioproduktion.3 Dieses Dossier analysiert die technologische Evolution, die rechtlichen Rahmenbedingungen und die architektonischen Innovationen, die es ermöglichen, Musik von kommerzieller Güteklasse auf herkömmlicher Konsumenten-Hardware zu erzeugen.

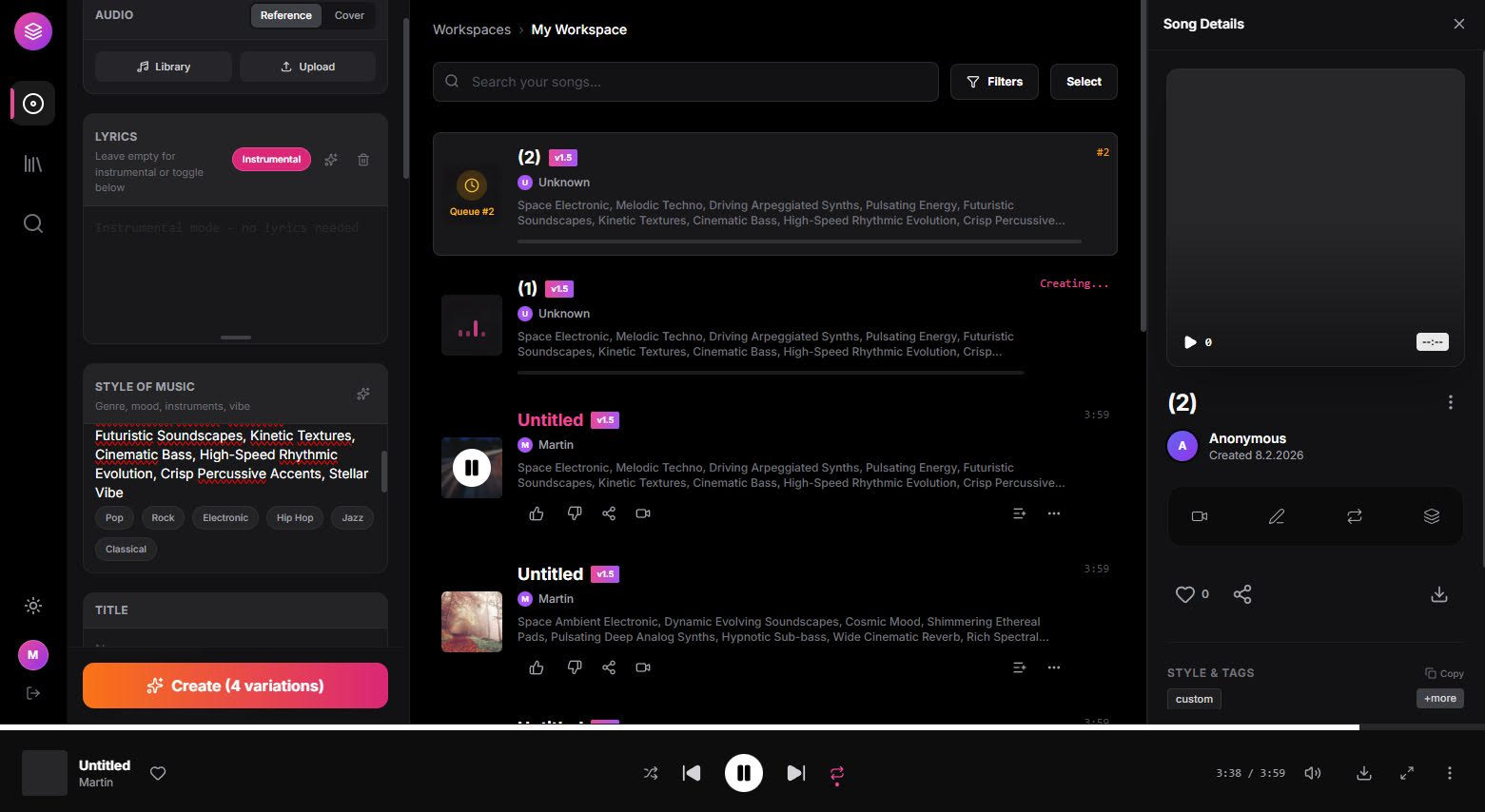

Soundbeispiel ohne Focals

Soundbeispiel mit Focals

Prompt: 90s Space Night style, Chill-out, Ambient, Downtempo, Cosmic, Ethereal Synth Pads, Lush Reverb, Slow Pacing, Atmospheric, Relaxing, Soft Electronic Percussion, Liquid Textures, High Fidelity

Genese und historische Entwicklung

Die Entstehungsgeschichte von ACE-Step 1.5 ist untrennbar mit der synergetischen Kooperation zwischen ACE Studio und StepFun verbunden.4 In einer Industrie, die oft durch strikte Geheimhaltung gekennzeichnet ist, stellt dieses Projekt ein bemerkenswertes Beispiel für kollaborative Open-Source-Entwicklung dar. Die technologische Basis wurde durch die Bereitstellung massiver Rechenkapazitäten und Speicherinfrastrukturen seitens StepFun ermöglicht, während ACE Studio die Expertise in der Modellierung von Vokalsynthese und musikalischer Struktur einbrachte.4

Die Entwicklung verlief über mehrere Iterationsstufen, wobei die Version 1.5 eine fundamentale Neugestaltung der Inferenz-Logik darstellt. Im Vergleich zu rein sprachmodellbasierten Ansätzen, die in der Vergangenheit oft unter struktureller Instabilität und hohen Latenzen litten, konnte die Geschwindigkeit bei ACE-Step 1.5 um den Faktor 100 gesteigert werden.5 Ein wesentlicher Meilenstein war hierbei der Übergang zu einer hybriden Architektur, die Planung und Ausführung voneinander trennt.4

Das Training des Modells stützte sich auf ein Fundament von circa 20 Millionen Text-zu-Musik-Paaren.6 In einer nachgeschalteten Feinabstimmungsphase, dem sogenannten „Omni-Task Fine-tuning“, wurde dieser Datensatz auf die qualitativ besten 50 % reduziert und durch 6 Millionen stammseparierte Spuren ergänzt, um komplexe Bearbeitungsfunktionen wie das „Repainting“ oder die „Track Extraction“ zu ermöglichen.6 Die folgende Tabelle skizziert die wichtigsten Meilensteine der Projektentwicklung:

| Phase | Fokus | Ergebnis |

| Foundation Pre-training | Erfassung allgemeiner akustischer Verteilungen | Modellierung von 20 Mio. Audiopaaren.6 |

| Omni-Task Fine-tuning | Erweiterte Bearbeitungsfunktionen | Integration von Cover- und Repaint-Funktionen.6 |

| Distillation Phase | Inferenz-Optimierung | Reduktion der Schritte auf 4–8 für Turbo-Modelle.6 |

| Release 1.5 (Feb 2026) | Open-Source-Freigabe | Verfügbarkeit unter MIT-Lizenz für die Öffentlichkeit.1 |

Rechtlicher Rahmen und Lizenzierungsmodell

Ein entscheidendes Differenzierungsmerkmal von ACE-Step 1.5 gegenüber Wettbewerbern wie Suno oder Udio ist die gewählte Lizenzierungsstrategie. Das Modell steht unter der MIT-Lizenz, einer der liberalsten Lizenzen im Softwarebereich.3 Diese Entscheidung hat weitreichende Implikationen für die kommerzielle Nutzbarkeit: Anwender können die generierten Werke ohne Lizenzgebühren oder restriktive Auflagen in professionelle Produktionen integrieren.3

Die ethische Integrität des Modells wird durch die Beschaffenheit der Trainingsdaten untermauert. ACE-Step 1.5 wurde ausschließlich auf lizenzierten Inhalten, urheberrechtsfreiem Material und synthetisch generierten Daten trainiert.3 Dies eliminiert die rechtliche Unsicherheit, die viele andere generative Modelle umgibt, welche oft auf ungeklärten Datensätzen basieren.7 Für professionelle Anwender bedeutet dies eine „Commercial-Ready“-Garantie, die den Einsatz in Filmen, Spielen und Werbeproduktionen rechtlich absichert.2

Die Architektur der zwei Gehirne: Planung trifft auf Handwerk

Die außergewöhnliche Geschwindigkeit und Qualität von ACE-Step 1.5 resultiert aus einer strikten Trennung der kognitiven Aufgaben innerhalb des Modells. Die Entwickler implementierten eine „Decoupled Usability-Generation Architecture“, die das Problem der Audioerzeugung in zwei spezialisierte Domänen unterteilt: den Planer und den Handwerker.4

Das Sprachmodell als omnipotenter Planer

Im Zentrum steht ein 5Hz-Sprachmodell (Language Model, LM), das als strategischer Planer fungiert.4 Anstatt direkt Audio zu erzeugen, transformiert das LM die oft vagen Nutzeranfragen mittels „Chain-of-Thought“-Prozessen in eine präzise semantische Blaupause.4 Diese Blaupause umfasst technische Metadaten wie BPM, Tonart, Zeitstruktur und semantische Codes, welche die DNA der Melodie und der Orchestrierung enthalten.9 Durch diese Abstraktionsebene wird sichergestellt, dass das Modell komplexe Anweisungen über eine Dauer von bis zu 10 Minuten kohärent verarbeiten kann.4

Der Diffusion Transformer als akustischer Exekutor

Die zweite Komponente ist der Diffusion Transformer (DiT), der die Rolle des akustischen Handwerkers übernimmt.9 Seine Aufgabe ist es, die vom LM gelieferten semantischen Codes in hochfrequente Audiosignale zu übersetzen. Der DiT „meißelt“ das finale Audio aus digitalem Rauschen heraus.9 Da der DiT von der Aufgabe der strukturellen Planung befreit ist, kann er seine gesamte Rechenkapazität auf die Erzeugung von Klangtexturen, das Mixing und die feinsten instrumentalen Details konzentrieren.4

Analyse der Geschwindigkeit und VRAM-Optimierung

Die Fähigkeit, ACE-Step 1.5 auf Konsumenten-Grafikkarten mit lediglich 8 GB VRAM – oder sogar weniger als 4 GB – zu betreiben, ist das Ergebnis mehrerer technologischer Durchbrüche.1 In einer Domäne, in der bisherige Spitzenmodelle oft industrielle Rechenzentren erforderten, demokratisiert ACE-Step 1.5 den Zugang zu professioneller Musikproduktion.4

Distillation: Von der Skizze zum Meisterwerk in 8 Schritten

Traditionelle Diffusionsmodelle benötigen oft 50 bis 100 Inferenzschritte, um klares Audio zu erzeugen, was den Prozess auf lokaler Hardware extrem verlangsamt. ACE-Step 1.5 nutzt ein spezialisiertes Distillationsprotokoll, welches die Inferenz-Trajektorie auf lediglich 4 bis 8 Schritte komprimiert.4 Diese Optimierung ermöglicht eine sub-sekündliche Generierung auf professionellen GPUs und hält die Generierungszeit auf Mittelklasse-Karten wie einer RTX 3060 oder 4060 weit unter der Dauer des eigentlichen Songs.1

Die folgende Tabelle verdeutlicht die Performance-Unterschiede auf verschiedenen Hardware-Plattformen:

| Hardware | VRAM | Geschwindigkeit (60s Audio) | Besonderheit |

| NVIDIA A100 | 40/80 GB | < 2 Sekunden 4 | Maximale Batch-Verarbeitung |

| RTX 3090 | 24 GB | < 10 Sekunden 1 | Hohe Inferenz-Stabilität |

| RTX 4060/3060 | 8 GB | ~ 20 Sekunden 11 | Optimale Preis-Leistung |

| Einstiegs-GPUs | < 4 GB | < 60 Sekunden 1 | Erfordert CPU-Offloading 9 |

Speicher-Ökonomie durch Quantisierung und Offloading

Für Nutzer mit begrenztem Grafikspeicher bietet das Modell mehrere Strategien. Durch die Unterstützung von FP8-Optimierungen kann der Speicherbedarf während des Trainings und der Inferenz signifikant gesenkt werden.13 Zudem ermöglicht die Software das „CPU-Offloading“, bei dem Teile des Sprachmodells in den Systemspeicher (RAM) ausgelagert werden, wenn der VRAM der Grafikkarte nicht ausreicht.9 Ein weiterer architektonischer Kniff ist die Wahl des Modells: Für 8-GB-Karten wird oft das 0.6B- oder 1.7B-LM-Modell empfohlen, um einen Puffer für den DiT-Prozess zu lassen.9

Ein technisches Detail, das zur Effizienz beiträgt, ist der Einsatz des Muon-Optimizers anstelle des Standard-AdamW-Algorithmus.6 Muon zeigt überlegene Konvergenzeigenschaften bei massiven 1D-Faltungsschichten, was nicht nur das Training stabilisiert, sondern auch die Inferenz-Effizienz verbessert.6 In Kombination mit einem 1D-VAE (Variational Autoencoder) erreicht das Modell eine höhere Rekonstruktionsqualität als 2D-basierte Ansätze, insbesondere bei der Trennung von Gesang und Begleitung.6

Das Omni-Task Framework: Vielseitigkeit jenseits von Text-zu-Musik

ACE-Step 1.5 ist nicht auf die einfache Generierung von Musik aus Textbeschreibungen beschränkt. Es etabliert ein einheitliches Framework für vielfältige musikalische Manipulationsaufgaben.4 Diese Vielseitigkeit macht es zu einem integralen Werkzeug für den gesamten kreativen Workflow, von der ersten Skizze bis zum finalen Mastering.14

Das Modell unterstützt nativ sechs primäre Aufgabentypen:

- Text2Music: Die klassische Generierung basierend auf Stilbeschreibungen und Lyrics.9

- Cover: Die Transformation bestehender Audiospur-Strukturen in neue Genres oder Klangfarben.9

- Repaint: Gezielte Regeneration spezifischer Zeitsegmente eines Songs, um Fehler zu korrigieren oder Variationen einzufügen.9

- Lego: Das Hinzufügen spezifischer Instrumentenspuren (z. B. Schlagzeug zu einer bestehenden Gitarrenspur) im Kontext des vorhandenen Materials.9

- Extract: Die Trennung von gemischtem Audio in Einzelspuren (Stems), wie etwa die Isolierung von Vocals.9

- Complete: Die Erzeugung einer passenden Begleitung für eine einzelne Spur, beispielsweise das Hinzufügen von Gitarre und Schlagzeug zu einem A-cappella-Gesang.9

Diese Funktionen werden durch eine intuitive Steuerung ermöglicht, bei der das DiT-Modell als „kreativer Brainstorming-Partner“ fungiert.9 In Modi wie Repaint nutzt der DiT das Referenz-Audio als harten Kontext, um Konsistenz in Klangfarbe und Mixing zu gewährleisten, während er lokal neue kreative Ideen einbringt.9

Methodik der Prompt-Synthese und strukturelle Kontrolle

Um das volle Potenzial von ACE-Step 1.5 auszuschöpfen, ist ein Verständnis der dualen Eingabestruktur erforderlich. Das System verwendet zwei getrennte Textfelder: eines für die Stilbeschreibung (Caption) und eines für die Songtexte (Lyrics).16

Dimensionen der Stilbeschreibung

Die Caption fungiert als globale Anweisung für das Modell. Hier sollten Dimensionen wie Genre, Emotion, Instrumentierung, Klangtextur und Produktionsstil definiert werden.9 Eine präzise Caption vermeidet Ambiguität und erlaubt es dem DiT, seine generative Kapazität optimal zu nutzen.4 Die folgende Tabelle zeigt exemplarische Parameter für eine effektive Stilsteuerung:

| Dimension | Beschreibung | Beispiele |

| Atmosphäre | Emotionale Grundstimmung | melancholisch, energetisch, verträumt, nostalgisch.9 |

| Instrumentierung | Spezifische Klangerzeuger | Akustikgitarre, 808-Drums, Synthesizer-Pads.9 |

| Ära/Referenz | Zeitlicher Kontext | 80er Synth-Pop, moderner Trap, 90er Grunge.9 |

| Produktion | Akustische Qualität | Lo-Fi, Studio-Polished, Live-Aufnahme.9 |

| Vokale Textur | Charakter der Stimme | heiser (raspy), kraftvoll, Flüstern, Falsett.9 |

Lyrics als temporales Skript

Die Lyrics sind weit mehr als nur zu singender Text; sie dienen als Zeitplan für die musikalische Entwicklung. Durch den Einsatz spezifischer Tags in eckigen Klammern kann die Dynamik und Struktur des Songs exakt gesteuert werden.9 Tags wie [Intro], [Chorus] oder “ signalisieren dem Modell, wann ein Energieaufbau oder ein emotionaler Höhepunkt erfolgen soll.9

Besonders leistungsfähig ist die Kombination von Inhaltsbeschreibung und Strukturvorgabe. Ein Tag wie “ innerhalb der Lyrics erzwingt eine instrumentale Sektion, während [raspy vocal] die Gesangsqualität für den folgenden Textabschnitt moduliert.9 Diese granulare Kontrolle ist ein wesentlicher Vorteil gegenüber älteren Modellen, die oft dazu neigten, Texte wahllos über das gesamte Arrangement zu verteilen.9

Hardware-spezifische Implementierung und Deployment

Die Flexibilität von ACE-Step 1.5 zeigt sich auch in der breiten Unterstützung verschiedener Hardware-Ökosysteme. Während NVIDIA-GPUs durch CUDA-Unterstützung die Standardplattform bilden, bietet ACE-Step 1.5 durch AMD ROCm 7.2 und Intel XPU-Support eine echte Hardware-Agnostik.3

Lokale Installation und Konfiguration

Für Windows-Nutzer wird oft ein portables Paket angeboten, das alle Abhängigkeiten enthält und zeitaufwendige Installationen vermeidet.10 Die Integration in Umgebungen wie ComfyUI erlaubt es zudem, ACE-Step 1.5 in knotenbasierte Workflows einzubinden, was insbesondere für professionelle Anwender, die Musik direkt für visuelle Medien generieren, von Vorteil ist.1

Ein kritischer Aspekt bei der lokalen Ausführung auf 8-GB-Karten ist das Management der DataLoader-Worker. In Umgebungen wie Gradio kann es zu Instabilitäten kommen, wenn zu viele parallele Prozesse den VRAM fragmentieren.13 Hier wird empfohlen, die Anzahl der Worker auf Null zu setzen, um Speicherlecks zu vermeiden und die Inferenz stabil zu halten.13 Für Nutzer von Apple Silicon (Mac) wurde zudem eine Unterstützung für das MPS-Backend (Metal Performance Shaders) implementiert, was die lokale Generierung auch auf Mac-Hardware ermöglicht.10

10 Beispiel-Prompts für verschiedene Musik-Genres

Die folgenden Beispiele illustrieren, wie die Synergie zwischen Caption und Lyrics genutzt werden kann, um konsistente und stilistisch präzise Ergebnisse zu erzielen.

1. Cyberpunk / Industrial Electro

- Stil: Dark cyberpunk, distorted industrial techno, heavy 808 sub-bass, cold metallic textures, 105 BPM, gritty production, robotic female vocals with glitch effects.

- Lyrics:

[Intro – ominous synth drone]

[Verse]

Neon blood in silicon veins,

Digital gods and electric chains.

“

[Chorus – explosive energy]

The system screams, the circuit breaks,

In the shadow of the great mistakes.

[Outro – fading static]

2. Lo-Fi Hip Hop / Study Chill

- Stil: Chill lofi hiphop, dusty vinyl crackle, relaxed boom-bap drums, jazzy Rhodes piano chords, mellow upright bass, cozy bedroom atmosphere, 85 BPM, intimate male whispered vocals.

- Lyrics:

[Intro – vinyl noise and soft rain]

[Verse]

[whispered]

Coffee’s cold but the vibe is right,

Watching city lights dance through the night.

[Instrumental – piano melody focus]

[Chorus]

Just let the rhythm flow,

Where it goes, I don’t know.

[Outro – slow fade out]

3. Epic Orchestral / Film Score

- Stil: Epic cinematic film score, powerful orchestral arrangement, soaring string section, thunderous taiko drums, heroic brass fanfares, gothic choir backgrounds, 90 BPM, grand atmosphere.

- Lyrics:

[Intro – low string swell]

[Verse – choir chanting]

Aeterna fati, ignis et gloria.

`[Chorus – powerful belting male vocals]` Through the storm, we find our home!

[Outro – final brass chord]

4. 80s Synthwave / Retrowave

- Stil: 80s synthwave, nostalgic neon atmosphere, driving analog synth bass (Juno-60 style), lush pads, gated reverb drums, 115 BPM, melodic male vocals with heavy reverb.

- Lyrics:

[Intro – arpeggiated synth melody]

[Verse]

Driving fast on the midnight coast,

Chasing the shadows of a summer ghost.

[Chorus – catchy pop melody]

Digital dreams in a world of chrome,

Finding a way to lead us home.

“

[Outro]

5. Modern Progressive Metal

- Stil: Progressive heavy metal, complex djent riffs, technical drumming, atmospheric synth layers, dual distorted guitars, 140 BPM, powerful raspy male vocals.

- Lyrics:

[Intro – technical drum fill]

[Verse – tight chugging riffs]

Fragmented thoughts in a hollow shell,

Creating the architecture of our own hell.

[Chorus – melodic and soaring]

Break the cycle, see the light,

Emerging from the endless night.

“

REWRITE THE CODE!

[Outro]

6. Traditional Delta Blues

- Stil: Authentic delta blues, resonator guitar, rhythmic foot stomps, soulful raspy male vocals, gritty raw production, 75 BPM, intimate live recording feel.

- Lyrics:

[Intro – slide guitar riff]

[Verse]

Woke up this morning with the devil at my door,

Said I can’t take this misery no more.

[Chorus]

Oh, the river’s rising, the sky is turning black.

“

[Outro – slow stomp ending]

7. J-Pop / Anime Theme

- Stil: Energetic J-pop, driving electronic beat, catchy synth melodies, bright female vocals (Japanese style), fast-paced 160 BPM, uplifting atmosphere, crisp studio production.

- Lyrics:

[Intro – bright synth hook]

[Verse]

Hikari no naka de yume o mite,

Kimi no egao o sagashite iru.

[Chorus – high energy]

Sparkling heart, eternal dream,

Nothing is ever as it seems!

“

[Outro]

8. Deep House / Ibiza Sunset

- Stil: Ibiza lounge deep house, Balearic Mediterranean warmth, 122 BPM, punchy sidechain pump, warm groovy bassline, crisp organic percussion (congas/shakers), ethereal breathy female vocals.

- Lyrics:

[Intro – simple kick and hi-hats]

[Verse]

Golden hour on the terrace floor,

Feeling the waves wash upon the shore.

[Chorus – whispered]

Let it flow… let it go…

[Outro]

9. Dark Folk / Gothic Americana

- Stil: Dark melancholic folk, acoustic guitar fingerpicking, haunting cello, deep baritone male vocals, intimate raw atmosphere, 70 BPM, minimal production.

- Lyrics:

[Intro – simple acoustic guitar]

[Verse]

The crows are silent in the hanging tree,

Waiting for the wind to set them free.

[Chorus – melancholic harmonies]

Dust to dust, and bone to bone,

In the end, we walk alone.

[Outro – fading cello]

10. Modern Afrobeat

- Stil: Vibrant afrobeat, syncopated drum patterns, warm bass guitar, bright horn sections, rhythmic male vocals with call and response, 105 BPM, summer party atmosphere.

- Lyrics:

[Intro – percussion groove]

[Verse]

Dance to the rhythm of the city soul,

Let the fire inside take full control.

[Chorus – call and response]

Everybody sing! (Sing it loud!)

Everybody move! (In the crowd!)

“

[Outro]

Evaluation und technologischer Vergleich

In der Fachwelt wird ACE-Step 1.5 oft mit Suno v4.5 oder v5 verglichen.10 Während kommerzielle Cloud-Modelle oft eine noch höhere „Politur“ in den finalen Vokalsynthesen aufweisen können, bietet ACE-Step 1.5 eine überlegene Kontrolle über die musikalische Struktur.4 Nutzerberichte heben hervor, dass ACE-Step insbesondere bei der Einhaltung von Prompts und der multilingualen Aussprache neue Maßstäbe setzt.3

Ein wesentlicher Vorteil von ACE-Step ist die Abwesenheit von strukturellen Artefakten, die bei rein Token-basierten Modellen oft auftreten.2 Durch die Verwendung von Diffusions-Synthese und DCAE (Deep Convolutional Autoencoders) erreicht das Modell eine harmonische Kohärenz, die den „unheimlichen“ Charakter mancher KI-Generierungen minimiert.2 Dennoch gibt es Stimmen, die darauf hinweisen, dass die Vokale in manchen Kontexten noch mechanisch klingen können, was jedoch durch Feinabstimmung mittels LoRA (Low-Rank Adaptation) adressiert werden kann.4

Schlussbetrachtung und Zukunftsausblick

ACE-Step 1.5 repräsentiert mehr als nur einen technologischen Fortschritt; es ist ein Manifest für die Autonomie der Kulturschaffenden. Durch die drastische Senkung der Hardware-Einstiegshürden und die Bereitstellung unter einer freien Lizenz verschiebt sich das Machtgefüge in der Musikproduktion weg von zentralisierten Diensten hin zum individuellen Künstler.3

Die Fähigkeit des Modells, als „omni-fähiger Planer“ komplexe musikalische Aufgaben zu bewältigen, ebnet den Weg für Werkzeuge, die nahtlos in professionelle Workflows integriert werden können.4 Ob es sich um adaptive Spielemusik handelt, die in Echtzeit auf das Gameplay reagiert, oder um die schnelle Erstellung von Demo-Tracks für Songwriter – ACE-Step 1.5 bietet die notwendige Geschwindigkeit und Flexibilität.3

Zukünftige Entwicklungen werden voraussichtlich die Inferenz-Effizienz weiter steigern und die Möglichkeiten zur Personalisierung durch LoRA-Training vereinfachen.4 Die hier analysierten architektonischen Entscheidungen – insbesondere die Trennung von LM und DiT sowie die aggressive Inferenz-Distillation – bilden das solide Fundament für eine neue Ära der demokratisierten, lokalen und qualitativ hochwertigen Musikproduktion.4

Referenzen

- Introducing ACE-Step 1.5, a music generation AI capable of generating high-quality vocal music at lightning speed. It can run locally on PCs with less than 4GB of VRAM and supports LoRA. – GIGAZINE, Zugriff am Februar 8, 2026, https://gigazine.net/gsc_news/en/20260204-ace-step-music-generation/

- ACE-Step: AI Song Generator for Random Song Creation, Zugriff am Februar 8, 2026, https://acestep.io/

- Commercial-grade AI music generation on AMD Ryzen™ AI processors and Radeon™ graphics with ACE Step 1.5, Zugriff am Februar 8, 2026, https://www.amd.com/en/blogs/2026/commercial-grade-ai-music-generation-on-amd-ryzen-ai-and-radeon-ace-step-1-5.html

- ACE-Step 1.5: Pushing the Boundaries of Open-Source Music Generation – arXiv, Zugriff am Februar 8, 2026, https://arxiv.org/html/2602.00744v1

- ACE-Step 1.5 Preview – “Pushing the Boundaries of Open-Source Music Generation” (<4GB VRAM!) coming on February 3rd : r/accelerate – Reddit, Zugriff am Februar 8, 2026, https://www.reddit.com/r/accelerate/comments/1qrmisk/acestep_15_preview_pushing_the_boundaries_of/

- ACE-Step 1.5: Pushing the Boundaries of Open-Source Music Generation – arXiv, Zugriff am Februar 8, 2026, https://www.arxiv.org/pdf/2602.00744v2

- ACE-Step/Ace-Step1.5 – Hugging Face, Zugriff am Februar 8, 2026, https://huggingface.co/ACE-Step/Ace-Step1.5

- The open-source version of Suno is finally here: ACE-Step 1.5 : r/LocalLLaMA – Reddit, Zugriff am Februar 8, 2026, https://www.reddit.com/r/LocalLLaMA/comments/1quxtkj/the_opensource_version_of_suno_is_finally_here/

- ACE-Step 1.5 Ultimate Guide (Must Read) – GitHub, Zugriff am Februar 8, 2026, https://github.com/ace-step/ACE-Step-1.5/blob/main/docs/en/Tutorial.md

- ace-step/ACE-Step-1.5: The most powerful local music generation model that outperforms most commercial alternatives – GitHub, Zugriff am Februar 8, 2026, https://github.com/ace-step/ACE-Step-1.5

- ACE-Step: Generate AI music locally in 20 seconds (runs on 8GB VRAM) : r/artificial – Reddit, Zugriff am Februar 8, 2026, https://www.reddit.com/r/artificial/comments/1q6mfoe/acestep_generate_ai_music_locally_in_20_seconds/

- Comparison Suno versus Ace-Step 1.5 – Two songs with audio and parameters : r/StableDiffusion – Reddit, Zugriff am Februar 8, 2026, https://www.reddit.com/r/StableDiffusion/comments/1qwab8d/comparison_suno_versus_acestep_15_two_songs_with/

- AceStep1.5 Local Training and Inference Tool Released. : r/StableDiffusion – Reddit, Zugriff am Februar 8, 2026, https://www.reddit.com/r/StableDiffusion/comments/1qxeqyh/acestep15_local_training_and_inference_tool/

- ACE-Step-1.5: Text2Music Model with Various Tasks and MIT License : r/AudioAI – Reddit, Zugriff am Februar 8, 2026, https://www.reddit.com/r/AudioAI/comments/1qvavkg/acestep15_text2music_model_with_various_tasks_and/

- Pushing the Boundaries of Open-Source Music Generation – ACE-Step 1.5, Zugriff am Februar 8, 2026, https://ace-step.github.io/ace-step-v1.5.github.io/

- How to Create AI Music with Ace Step V1.5 in ComfyUI – Next Diffusion, Zugriff am Februar 8, 2026, https://www.nextdiffusion.ai/tutorials/how-to-create-ai-music-with-ace-step-v15-in-comfyui

KI-gestützt. Menschlich veredelt.

Martin Käßler ist ein erfahrener Tech-Experte im Bereich AI, Technologie, Energie & Space mit über 15 Jahren Branchenerfahrung. Seine Artikel verbinden fundiertes Fachwissen mit modernster KI-gestützter Recherche- und Produktion. Jeder Beitrag wird von ihm persönlich kuratiert, faktengeprüft und redaktionell verfeinert, um höchste inhaltliche Qualität und maximalen Mehrwert zu garantieren.

Auch bei sorgfältigster Prüfung sehen vier Augen mehr als zwei. Wenn Ihnen ein Patzer aufgefallen ist, der uns entgangen ist, lassen Sie es uns bitte wissen: Unser Postfach ist martinkaessler, gefolgt von einem @ und dem Namen einer bekannten Suchmaschine (also googlemail) mit der Endung .com. Oder besuchen Sie Ihn gerne einfach & direkt auf LinkedIn.