Nvidia Vera Rubin: Die neue Architektur für künstliche Intelligenz

Einleitung: Der Phasenübergang der künstlichen Intelligenz

Im Januar 2026 vollzog die Welt der Hochleistungsrechner einen entscheidenden Wandel. Auf der Consumer Electronics Show (CES) in Las Vegas enthüllte Jensen Huang, der CEO von Nvidia, die Vera Rubin Plattform. Diese Ankündigung war weit mehr als die bloße Vorstellung eines neuen Mikrochips; sie markierte den offiziellen Beginn einer neuen industriellen Ära: das Zeitalter der “Agentic AI” (agentischen KI) und der physikalischen KI.1

Benannt nach der US-amerikanischen Astronomin Vera Rubin, deren bahnbrechende Beobachtungen der Rotationsgeschwindigkeiten von Galaxien den ersten robusten Beweis für die Existenz dunkler Materie lieferten, zielt die gleichnamige Plattform darauf ab, das bisher “Unsichtbare” in der Computerwelt greifbar zu machen: die Fähigkeit von Maschinen, komplexe, mehrstufige Gedankengänge zu planen, zu orchestrieren und physisch in der realen Welt zu agieren.2 Während die vorangegangene Blackwell-Architektur das Fundament für das Training massiver Sprachmodelle legte, ist Rubin darauf ausgelegt, diese Modelle von passiven Chatbots in aktive Agenten zu verwandeln, die logisch schlussfolgern und Aufgaben autonom erledigen.

Dieser Bericht bietet eine erschöpfende technische und strategische Analyse der Vera Rubin Plattform. Er ist als Kompendium konzipiert, das die Brücke schlägt zwischen hochkomplexer Halbleiterphysik und den verständlichen, gesellschaftlichen Auswirkungen dieser Technologie. Wir werden die zugrundeliegende Silizium-Architektur, die Revolution des Speichers, die Neudefinition des Rechenzentrums als “Computer” und die geopolitischen sowie ökonomischen Welleneffekte untersuchen, die von diesem technologischen Monolithen ausgehen.

Kapitel 1: Die Genese der KI-Fabrik – Vom Chip zum System

Um die Dimension der Rubin-Plattform zu verstehen, muss man sich von der Vorstellung lösen, dass ein Computer aus einzelnen, diskreten Bauteilen besteht, die man beliebig zusammenstecken kann. Die Ära, in der man eine schnellere CPU kaufte, um einen schnelleren Computer zu haben, ist im Bereich der Hochleistungs-KI vorbei. Nvidia hat mit Rubin das Konzept des “Extreme Co-Design” auf die Spitze getrieben.1

1.1 Das Ende des Mooreschen Gesetzes und der Weg zu “Scale-Up”

Jahrzehntelang verließ sich die IT-Industrie auf das Mooresche Gesetz – die Beobachtung, dass sich die Anzahl der Transistoren auf einem Chip etwa alle zwei Jahre verdoppelt. Doch physikalische Grenzen machen diese Skalierung immer teurer und schwieriger. Gleichzeitig wächst der Hunger der KI-Modelle exponentiell: Die Anzahl der Parameter in führenden Modellen verzehnfacht sich jährlich, während die Menge der generierten Daten (Token) sich verfünffacht.4

Die Antwort der Industrie darauf ist nicht mehr nur der “schnellere Chip”, sondern das “größere System”. Die Rubin-Plattform betrachtet nicht den einzelnen Prozessor als die Recheneinheit, sondern das gesamte Server-Rack, ja sogar das gesamte Rechenzentrum.3

1.2 Die Philosophie der sechs Chips

Nvidia hat erkannt, dass ein einziger Flaschenhals im System die Leistung von Tausenden von Prozessoren zunichtemachen kann. Daher besteht die Rubin-Plattform nicht aus einem, sondern aus sechs neu entwickelten, synergetisch arbeitenden Chips 1:

- Rubin GPU: Der Muskel, der die massiven parallelen Berechnungen durchführt.

- Vera CPU: Das Gehirn, das die Datenströme orchestriert und komplexe Logik verarbeitet.

- NVLink 6 Switch: Das Nervensystem, das Chips schneller verbindet, als Daten im Internet fließen.

- ConnectX-9 SuperNIC: Die Schnittstelle zur Außenwelt für massive Datenübertragung.

- BlueField-4 DPU: Der Sicherheits- und Verwaltungsoffizier, der Infrastrukturaufgaben übernimmt.

- Spectrum-X6 Ethernet Switch: Der Verkehrsleiter für das gesamte Rechenzentrum.

Diese Komponenten wurden nicht isoliert entwickelt, sondern in einem integrierten Prozess (“Extreme Co-Design”), um sicherzustellen, dass sie als eine einzige, monolithische Maschine funktionieren.5

Kapitel 2: Vera Rubin GPU (R100) – Die Anatomie der Leistung

Das Herzstück der Plattform ist der Rubin Grafikprozessor (oft als R100 bezeichnet). Er repräsentiert die Spitze dessen, was physikalisch in der Halbleiterfertigung derzeit möglich ist.

2.1 Der 3nm-Prozess und die Transistor-Dichte

Die Rubin GPU wird im fortschrittlichen 3nm-Prozess (N3) von TSMC gefertigt.7 Dies ist ein signifikanter Sprung gegenüber dem 4NP-Prozess der Blackwell-Generation. Die Verkleinerung der Strukturbreiten auf 3 Nanometer erlaubt es Nvidia, 336 Milliarden Transistoren auf dem Chip unterzubringen – das ist das 1,6-fache der Transistorzahl von Blackwell.7

Zum Vergleich: Ein Transistor ist der grundlegende Schalter in einem Computer. Je mehr Schalter man hat, desto komplexere Berechnungen kann man gleichzeitig durchführen. Die Steigerung auf 336 Milliarden Schalter auf einer Fläche, die kaum größer ist als eine Briefmarke, grenzt an physikalische Zauberei und erfordert extremste Präzision in der Lithografie.

2.2 Das 4x Reticle Limit: Grenzen sprengen

Ein zentrales Problem der modernen Chipfertigung ist das sogenannte “Reticle Limit”. Dies bezeichnet die maximale Fläche, die eine Belichtungsmaschine (Scanner) in einem einzigen Schritt auf einen Silizium-Wafer projizieren kann. Ein Chip kann physikalisch nicht größer sein als dieses Belichtungsfenster – normalerweise etwa 858 mm².

Nvidia umgeht dieses Limit bei Rubin durch ein innovatives Chiplet-Design. Die Rubin GPU nutzt ein 4x Reticle Design.8 Das bedeutet, der fertige Prozessor ist effektiv viermal so groß wie der maximal mögliche Einzelchip. Dies wird erreicht, indem mehrere Silizium-Dies (Chiplets) separat gefertigt und dann auf einem riesigen Zwischenträger (Interposer) mittels CoWoS-L (Chip-on-Wafer-on-Substrate with Local Silicon Interconnect) Technologie von TSMC zusammengefügt werden.10 Für das System verhält sich dieser Verbund wie ein einziger riesiger Chip, obwohl er aus mehreren Teilen besteht.

2.3 NVFP4 und die Demokratisierung der Rechenkraft

Ein entscheidender Durchbruch der Rubin-Architektur liegt in der Art und Weise, wie gerechnet wird. Traditionelle Computer nutzen hohe Präzision (z.B. 32-Bit oder 64-Bit Gleitkommazahlen), um exakte Ergebnisse zu liefern. In der KI, besonders bei neuronalen Netzen, ist diese extreme Präzision oft nicht nötig. Es reicht zu wissen, dass ein Wert “ungefähr 0,5” ist, statt “0,50000012”.

Rubin führt eine massive Beschleunigung für das NVFP4-Format ein (4-Bit Floating Point).

- Die Innovation: Der Rubin-Chip liefert 50 Petaflops an NVFP4-Inferenzleistung.11 Das ist eine Verfünffachung gegenüber der Blackwell-Architektur.

- Die Bedeutung: Durch die Reduktion der Datenpräzision auf 4 Bit können Modelle viel schneller berechnet werden und verbrauchen weniger Speicher. Ein “Transformer Engine” der dritten Generation sorgt dafür, dass die Genauigkeit des KI-Modells trotz dieser extremen Kompression erhalten bleibt.11 Dies ist der Schlüssel, um die Kosten pro generiertem Wort (Token) um den Faktor 10 zu senken.13

| Spezifikation | Nvidia Blackwell (B200) | Nvidia Rubin (R100) | Faktor der Verbesserung |

| Fertigungsprozess | TSMC 4NP | TSMC 3nm (N3) | Höhere Dichte |

| Transistoren | ~208 Milliarden | 336 Milliarden | ~1.6x |

| Inferenz-Leistung (NVFP4) | 10 PFLOPS | 50 PFLOPS | 5x |

| Speichertechnologie | HBM3e | HBM4 | Generationssprung |

| Speicherbandbreite | 8 TB/s | 22 TB/s | 2.8x |

Kapitel 3: HBM4 – Der Speicher wird intelligent

Wenn die GPU der Motor ist, dann ist der Speicher der Tank. In den letzten Jahren litten KI-Systeme unter der sogenannten “Memory Wall”: Die Rechenkerne wurden schneller, als Daten aus dem Speicher geliefert werden konnten. Die Rubin-Plattform durchbricht diese Mauer durch den erstmaligen Einsatz von HBM4 (High Bandwidth Memory Generation 4).8

3.1 Die Integration von Logik in den Speicher

Der revolutionärste Aspekt von HBM4 in der Rubin-Plattform ist nicht nur die Geschwindigkeit, sondern die Intelligenz. Traditioneller Speicher ist passiv; er speichert Daten und gibt sie heraus.

- Logic Base Die: Bei HBM4 besteht die unterste Schicht des Speicherstapels (Base Die) nicht mehr aus Speicherzellen, sondern aus Logik-Transistoren, gefertigt in einem 12nm oder sogar 5nm Prozess von TSMC.15

- Near-Memory Processing: Dies ermöglicht es, Rechenoperationen direkt im Speicherbaustein durchzuführen. Einfache, aber datenintensive Aufgaben – wie das Verwalten von Indizes oder Key-Value Caches für Sprachmodelle – müssen nicht mehr den langen Weg zur GPU und zurück antreten. Sie werden direkt “vor Ort” erledigt. Dies reduziert die Latenz drastisch und spart Energie, da weniger Daten bewegt werden müssen.15

3.2 Bandbreite jenseits der Vorstellungskraft

Jede Rubin GPU ist mit bis zu 288 GB HBM4 Speicher ausgestattet, der eine Bandbreite von 22 TB/s liefert.6

- Einordnung: 22 Terabyte pro Sekunde bedeutet, dass der Chip den Inhalt der gesamten Library of Congress (geschätzt auf etwa 20 Terabyte Textdaten) in weniger als einer Sekunde lesen könnte. Diese extreme Bandbreite ist notwendig, um die gigantischen Parameter-Matrizen moderner KI-Modelle in Echtzeit zu füttern.

Kapitel 4: Die Vera CPU – Der Dirigent des Orchesters

Während GPUs für parallele Aufgaben (wie Grafik oder KI-Matrizen) optimiert sind, benötigen komplexe Systeme eine CPU (Central Processing Unit) für serielle Aufgaben, Betriebssystemverwaltung und Datenlogistik. Nvidia hat hierfür die Vera CPU entwickelt, die die bisherige Grace-Architektur ablöst.

4.1 Spezialisierung statt Generalisierung

Im Gegensatz zu traditionellen x86-Prozessoren von Intel oder AMD, die als Allzweckwaffen für jeden Computertyp konzipiert sind, ist die Vera CPU ein hochspezialisierter Baustein für KI-Fabriken.

- Architektur: Vera basiert auf der Arm®-Architektur und nutzt 88 Custom “Olympus” Kerne.13

- Aufgabe: Ihre Hauptaufgabe ist nicht das Rechnen an sich, sondern die Datenbewegung und das Agentic Reasoning. Sie fungiert als Logistikzentrum, das sicherstellt, dass die GPUs niemals auf Daten warten müssen.

4.2 Spatial Multithreading für Determinismus

Ein einzigartiges Merkmal der Vera CPU ist das Spatial Multithreading mit 176 Threads.3

- Erklärung: Normale CPUs simulieren Multitasking, indem sie extrem schnell zwischen Aufgaben hin- und herspringen (Time Slicing). Das führt zu minimalen Verzögerungen (Jitter), die in einem Hochleistungssystem summieren können. Vera teilt die Ressourcen ihrer Kerne physisch auf (räumliches Multithreading). Das garantiert eine extrem vorhersehbare Leistung (“deterministische Latenz”). Wenn 72 GPUs synchron arbeiten müssen, darf der Taktgeber nicht stolpern.

4.3 Die Symbiose mit der GPU

Vera ist über NVLink-C2C (Chip-to-Chip) direkt mit den Rubin GPUs verbunden. Diese Verbindung bietet eine Bandbreite von 1,8 TB/s.3 Dadurch können CPU und GPU auf denselben Speicher zugreifen (“Unified Memory Architecture”). Für das Software-Modell bedeutet dies, dass es keinen Unterschied macht, ob Daten im CPU-RAM oder im GPU-VRAM liegen – das System sieht einen einzigen, riesigen Adressraum.

Kapitel 5: NVLink 6 und das NVL72 Rack – Der Computer ist das Netzwerk

Die wohl tiefgreifendste Innovation der Rubin-Plattform ist die Abschaffung des Konzepts des einzelnen Servers. In traditionellen Rechenzentren ist die Verbindung zwischen zwei Servern oft tausendmal langsamer als die Verbindung innerhalb eines Servers. Nvidia hat dieses Limit mit NVLink 6 beseitigt.

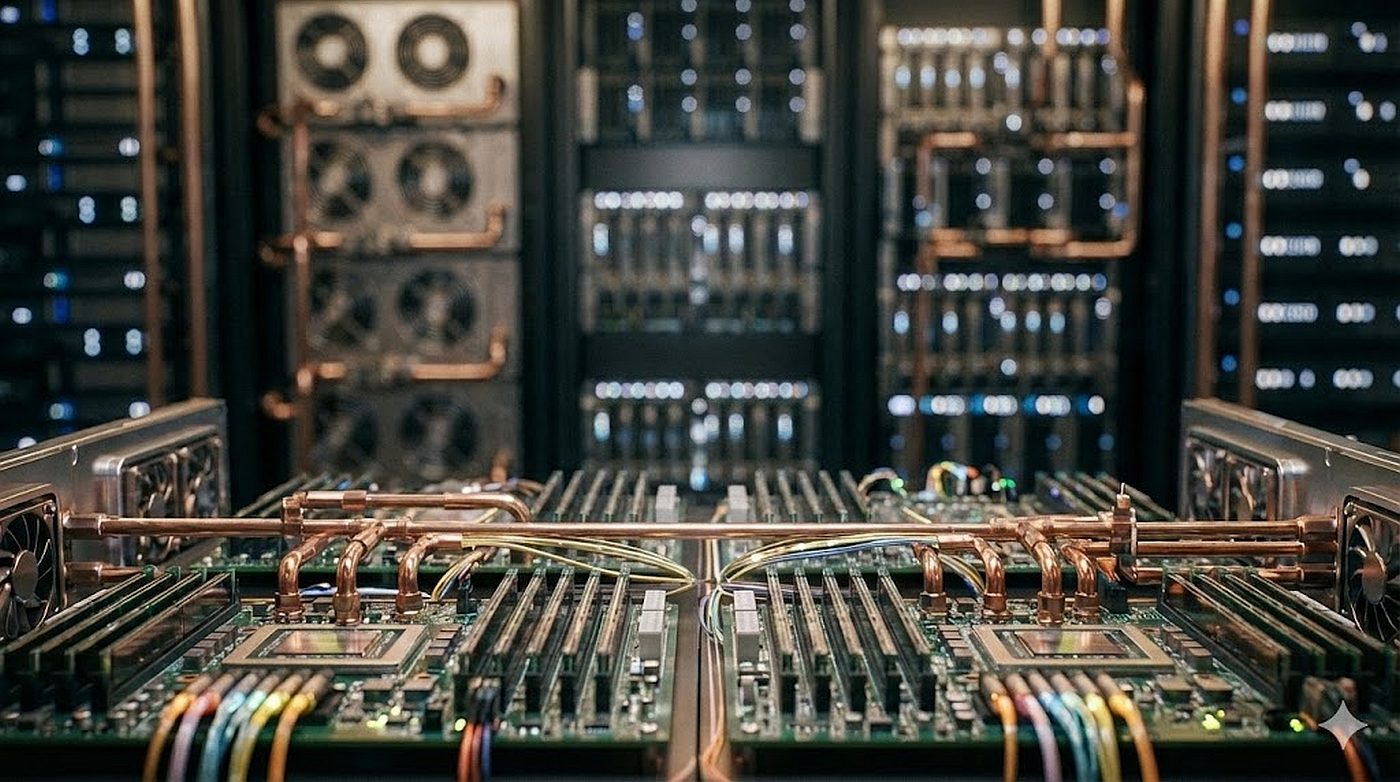

5.1 Das NVL72 Rack-System

Das Flaggschiff der Rubin-Ära ist das Vera Rubin NVL72 System. Es handelt sich um einen flüssigkeitsgekühlten Schrank (Rack), der als ein einziger, massiver Computer fungiert.

- Die Spezifikationen des Racks:

- 36 Vera CPUs und 72 Rubin GPUs.20

- 20,7 TB HBM4 Speicher (GPU) und 54 TB LPDDR5X Speicher (CPU).20

- Gewicht: Fast 2 Tonnen Hardware.21

- Rechenleistung: 3,6 Exaflops (3.600 Petaflops) an KI-Inferenzleistung.20

5.2 NVLink 6: Die Kupfer-Backplane

Innerhalb dieses Racks sind alle 72 GPUs über den NVLink 6 Switch miteinander verbunden.

- Bandbreite: NVLink 6 bietet 3,6 TB/s Bandbreite pro GPU.3

- Die Backplane: Anstatt Kabel zu verwenden, die Signalverluste und Latenz verursachen, stecken die Komponenten in einer massiven Kupfer-Rückwand (Backplane). Dies ermöglicht es jedem der 72 Chips, mit jedem anderen Chip im Rack so schnell zu kommunizieren, als säßen sie nebeneinander auf der Platine.

- Rack-Scale Bandbreite: Die gesamte Bisektionsbandbreite des Racks beträgt 260 TB/s.19 Um dies in Perspektive zu setzen: Das ist ein Vielfaches der Bandbreite des gesamten globalen Internetverkehrs. Dies ist notwendig, damit das System ein einzelnes, gigantisches KI-Modell (mit Billionen von Parametern) über alle 72 Karten verteilen kann, ohne dass die Kommunikation zum Flaschenhals wird.

5.3 Thermodynamik und “Hot Water Cooling”

Ein System dieser Dichte erzeugt enorme Abwärme. Berichte deuten darauf hin, dass die Leistungsaufnahme eines Rubin-Racks bis zu 600 kW erreichen kann.23 Zum Vergleich: Ein typisches Server-Rack vor zehn Jahren verbrauchte etwa 5-10 kW.

- Das Problem der Kühlung: Luftkühlung ist bei dieser Dichte physikalisch unmöglich. Man bräuchte Orkane im Serverraum.

- Die Lösung – 45°C Warmwasserkühlung: Jensen Huang präsentierte eine innovative Lösung. Das System wird mit Flüssigkeit gekühlt, die bis zu 45 Grad Celsius warm sein darf.25

- Der Vorteil: Da 45°C wärmer ist als die typische Außentemperatur in den meisten Regionen der Welt, benötigt man keine energiefressenden Kältemaschinen (Chiller), um das Wasser herunterzukühlen. Man kann einfache Trockenkühler (Dry Coolers) auf dem Dach verwenden, die die Wärme passiv an die Luft abgeben.

- Ökologische Auswirkung: Dies eliminiert einen der größten Energiefresser in Rechenzentren und ermöglicht eine signifikante Reduktion des Gesamtstromverbrauchs (“Power Usage Effectiveness” – PUE).

Kapitel 6: Die Ära der “Agentic AI” (Agentische KI)

Die technischen Spezifikationen der Rubin-Plattform dienen einem einzigen Zweck: Der Ermöglichung von Agentic AI. Doch was bedeutet das für den Laien?

6.1 Vom Chatbot zum Agenten

Die KI-Modelle der Jahre 2023-2025 (wie ChatGPT) waren primär “generativ”. Sie sagten das nächste Wort in einem Satz vorher. Man stellte eine Frage, und die KI generierte sofort eine Antwort.

- Das Limit: Diese Modelle “denken” nicht nach. Sie haben keinen inneren Monolog, prüfen ihre Fakten nicht und können keine langfristigen Pläne verfolgen.

- Agentic AI: Die neue Generation (ermöglicht durch Rubin) simuliert das “System 2”-Denken des Menschen (langsames, logisches Nachdenken). Ein KI-Agent erhält eine Aufgabe (“Plane eine Urlaubsreise für mich, buche Flüge und Hotels unter 2000€”). Der Agent zerlegt dies in Schritte, recherchiert, vergleicht Preise, prüft Verfügbarkeiten, korrigiert Fehler und führt die Buchung aus.11

6.2 Inference Context Memory Storage (ICMS)

Für diese Agenten ist das Gedächtnis entscheidend. Ein Agent, der über Stunden arbeitet, muss sich an Tausende von Zwischenschritten erinnern (“Context”).

- Das Problem: GPU-Speicher (HBM) ist extrem teuer und knapp. Ihn mit Kontextdaten zu füllen, ist Verschwendung.

- Die Lösung: Nvidia führte mit Rubin den Inference Context Memory Storage ein, angetrieben von der BlueField-4 DPU.26 Dies ist eine neue Ebene der Speicherarchitektur. Es erlaubt dem System, riesige Mengen an Kontext (Key-Value Cache) in einem günstigeren Speicher vorzuhalten und ihn blitzschnell über das Netzwerk in die GPU zu streamen, nur wenn er gebraucht wird. Es ist, als hätte die KI ein unendliches Kurzzeitgedächtnis, das nicht ihr Gehirn (die GPU) belastet.

6.3 Mixture-of-Experts (MoE) als Standard

Moderne “denkende” Modelle sind oft so groß, dass sie nicht mehr in einen einzelnen Chip passen. Sie nutzen eine Architektur namens Mixture-of-Experts (MoE). Das Modell besteht aus vielen spezialisierten Unter-Netzwerken (Experten). Für jede Frage werden nur die relevanten Experten aktiviert.

- Die Herausforderung: Die Daten müssen ständig zwischen den Experten hin- und herspringen, die auf verschiedenen GPUs liegen können.

- Rubins Vorteil: Dank NVLink 6 können Rubin-Systeme MoE-Modelle viel effizienter handhaben. Nvidia gibt an, dass Rubin MoE-Modelle mit einem Viertel der bisher benötigten GPUs trainieren kann und die Inferenzkosten um den Faktor 10 senkt.13 Dies macht hochkomplexe Agenten erstmals wirtschaftlich massentauglich.

Kapitel 7: Physical AI – Wenn die KI den Körper findet

Ein weiteres Kerngebiet der Rubin-Plattform ist die Physical AI – die Verschmelzung von digitaler Intelligenz mit physischen Robotern.

7.1 Projekt GR00T

Nvidia treibt mit Rubin das Projekt GR00T (Generalist Robot 00 Technology) voran.28 Das Ziel ist ein Basismodell für humanoide Roboter.

- Die Simulation: Um einen Roboter zu trainieren, kann man ihn nicht einfach in die echte Welt lassen (er würde fallen und kaputtgehen). Man trainiert ihn in einer physikalisch perfekten Simulation (Nvidia Omniverse). Rubin liefert die Rechenkraft, um Millionen dieser Simulationen parallel laufen zu lassen (“Digital Twins”). Die KI “lebt” tausende Jahre in der Simulation, bevor sie auch nur eine Sekunde in einem echten Roboter verbringt.

7.2 Alpamayo: Das denkende Auto

Für autonome Fahrzeuge stellte Nvidia die Alpamayo-Modellfamilie vor.30

- Reasoning im Verkehr: Alpamayo basiert auf “Reasoning”. Ein traditionelles autonomes Auto sieht einen Ball und bremst. Ein “Reasoning”-Auto sieht einen Ball, schlussfolgert “Ein Kind könnte hinterherlaufen”, analysiert die verdeckten Bereiche zwischen parkenden Autos und bereitet ein Ausweichmanöver vor, noch bevor das Kind sichtbar ist. Rubin ermöglicht die Ausführung dieser komplexen Gedankengänge in Echtzeit im Fahrzeug oder in der Cloud zur Validierung.

Kapitel 8: Wettbewerb und strategische Einordnung

Nvidia operiert nicht im Vakuum. Die Rubin-Plattform ist auch eine Antwort auf den wachsenden Druck der Konkurrenz.

8.1 AMD Helios und der Speicher-Krieg

Der Hauptrivale AMD positioniert seine Helios-Plattform (basierend auf MI400/MI450 Chips) gegen Rubin.32

- Der Vergleich: AMD setzt traditionell auf offene Standards und oft auf größere Speicherkapazitäten pro Chip. Frühe Vergleiche deuten darauf hin, dass AMDs Helios-Racks bei der reinen Speicherkapazität Vorteile haben könnten, was für bestimmte HPC-Anwendungen (High Performance Computing) wichtig ist.34

- Nvidias Antwort: Nvidia kontert mit der überlegenen Integration. Durch NVLink, die proprietären Vera CPUs und die CUDA-Software schafft Nvidia einen “Walled Garden” (geschlossenes Ökosystem), der eine Systemleistung liefert, die größer ist als die Summe der Teile.

8.2 Der “Moat” (Burggraben) der Integration

Rubin zementiert Nvidias Strategie, nicht mehr nur Komponentenlieferant zu sein, sondern Systemarchitekt. Indem Nvidia CPU, GPU, Netzwerk und Speichercontroller selbst entwickelt, wird es für Kunden (wie Microsoft oder Amazon) schwieriger, einzelne Teile gegen Konkurrenzprodukte auszutauschen. Ein Rubin-Supercomputer funktioniert am besten, wenn er zu 100% aus Nvidia-Technologie besteht.

Kapitel 9: Sicherheit und Confidential Computing

In einer Welt, in der KI medizinische Diagnosen stellt oder Finanztransaktionen prüft, ist Datensicherheit essenziell.

9.1 Verschlüsselung auf Rack-Ebene

Vera Rubin ist die erste Plattform, die Confidential Computing über das gesamte Rack hinweg ermöglicht.22

- Trusted Execution Environment (TEE): Bisher waren Daten sicher, solange sie auf dem Chip verarbeitet wurden. Sobald sie über Kabel zu einem anderen Chip reisten, waren sie theoretisch abfangbar. Rubin verschlüsselt den gesamten Datenverkehr auf dem NVLink-Bus. Die 72 GPUs und 36 CPUs bilden eine einzige, kryptografisch gesicherte Enklave.

- Anwendung: Dies ermöglicht es Krankenhäusern, sensible Patientendaten an einen Cloud-Provider zu senden, um eine Analyse durchzuführen, ohne dass der Cloud-Provider (oder Nvidia) jemals die unverschlüsselten Daten sehen kann. Selbst ein Administrator mit physischem Zugang zum Serverraum könnte die Daten nicht auslesen.

Kapitel 10: Ökonomische und geopolitische Implikationen

Die Einführung der Rubin-Plattform hat Auswirkungen, die weit über die Technologiebranche hinausgehen.

10.1 Energie als Währung

Mit einem Verbrauch von bis zu 600 kW pro Rack wird Energie zur kritischen Ressource.23 KI-Fabriken werden dort gebaut werden, wo Energie billig und grün ist, nicht dort, wo Internetknoten liegen. Die Effizienzsteigerung von Rubin (10x mehr Leistung pro Watt für Inferenz) ist daher nicht nur ein technisches Feature, sondern eine ökonomische Notwendigkeit, um den globalen Energiehunger der KI zu stillen.

10.2 Die Abhängigkeit von Taiwan

Die Fertigung der Rubin-Chips im 3nm-Prozess und die komplexe CoWoS-L Verpackung finden bei TSMC in Taiwan statt.4 Die Rubin-Plattform vertieft die Abhängigkeit der Weltwirtschaft von einer einzigen Insel und einer einzigen Firma. Jede geopolitische Störung in dieser Region hätte unmittelbare, katastrophale Auswirkungen auf den Rollout der nächsten KI-Generation.

10.3 Die Kosten der Intelligenz

Jensen Huangs Versprechen, die Kosten pro Token um den Faktor 10 zu senken, könnte eine Deflation der Intelligenzkosten auslösen.13 Wenn Intelligenz (in Form von KI-Arbeitsleistung) drastisch billiger wird, ermöglicht dies neue Geschäftsmodelle, bedroht aber auch traditionelle Wissensarbeitsplätze in einem bisher ungekannten Ausmaß.

Fazit: Das Fundament einer neuen Realität

Die Nvidia Vera Rubin Plattform ist ein technologisches Meisterwerk. Sie überwindet die Grenzen der Physik durch extreme Integration, neue Materialien und radikales Design.

- Technologisch markiert sie den Übergang vom 2D-Chip zum 2.5D/3D-System und die Verschmelzung von Speicher und Logik.

- Funktional ermöglicht sie den Sprung von der generativen KI (“Schreibe ein Gedicht”) zur agentischen KI (“Manage mein Projekt”).

- Infrastrukturell definiert sie das Rechenzentrum neu: weg von luftgekühlten Server-Reihen, hin zu flüssigkeitsgekühlten, monolithischen KI-Fabriken.

Für den Laien bedeutet Rubin: Die KI wird leiser, schneller und tiefgreifender in den Alltag integriert. Sie wird nicht mehr nur auf dem Bildschirm existieren, sondern durch Projekte wie GR00T und Alpamayo physisch in Robotern und Fahrzeugen präsent sein. Vera Rubin, die Astronomin, blickte in die Sterne und fand das Unsichtbare. Die Vera Rubin Plattform blickt in die Daten und soll eine neue Form der künstlichen Kognition erschaffen. Ob diese Entwicklung als Werkzeug oder als Umbruch empfunden wird, hängt davon ab, wie Gesellschaften diese massive neue Rechenkraft nutzen werden.

Tabellarische Übersicht: Die Rubin-Plattform im Detail

| Komponente | Spezifikation | Funktion & Bedeutung |

| Rubin GPU (R100) | 3nm TSMC, 4x Reticle, CoWoS-L | Der Rechenkern. 4x größer als normale Chips durch Zusammenfügen von Teilen. |

| Speicher | 288 GB HBM4, 22 TB/s Bandbreite | Extrem schneller Speicher mit integrierter Logik zur Datenverarbeitung. |

| Vera CPU | 88 Arm “Olympus” Kerne | Der Koordinator. Spezialisiert auf Datenlogistik und deterministische Steuerung. |

| NVLink 6 | 3,6 TB/s pro GPU, 260 TB/s pro Rack | Verbindet alle Chips zu einem virtuellen Super-Chip. |

| NVL72 Rack | 72 GPUs, 36 CPUs, ~600 kW | Die kleinste “Einheit” für KI-Supercomputing. Flüssigkeitsgekühlt (45°C). |

| Leistung | 50 PFLOPS (NVFP4) Inferenz | Verfünffachung der KI-Leistung gegenüber dem Vorgänger Blackwell. |

| Hauptzweck | Agentic AI, Physical AI | Ermöglicht denkende, planende KI-Agenten und Robotik-Simulationen. |

Referenzen

- Nvidia’s new Vera Rubin chips: 4 things to know, Zugriff am Januar 8, 2026, https://mashable.com/article/nvidia-new-vera-rubin-chip-things-to-know

- NVIDIA Rubin Platform, Open Models, Autonomous Driving: NVIDIA Presents Blueprint for the Future at CES, Zugriff am Januar 8, 2026, https://blogs.nvidia.com/blog/2026-ces-special-presentation/

- Inside the NVIDIA Rubin Platform: Six New Chips, One AI Supercomputer, Zugriff am Januar 8, 2026, https://developer.nvidia.com/blog/inside-the-nvidia-rubin-platform-six-new-chips-one-ai-supercomputer/

- Nvidia’s new AI computing platform makes leap with new TSMC-made chips, Zugriff am Januar 8, 2026, https://focustaiwan.tw/sci-tech/202601060016

- NVIDIA Releases Details on Next-Gen Vera Rubin AI Platform — 5X the Performance of Blackwell, Zugriff am Januar 8, 2026, https://insidehpc.com/2026/01/nvidia-releases-details-on-next-gen-vera-rubin-ai-platform-5x-the-performance-of-blackwell/

- Nvidia launches Vera Rubin NVL72 AI supercomputer at CES — promises up to 5x greater inference performance and 10x lower cost per token than Blackwell, coming 2H 2026, Zugriff am Januar 8, 2026, https://www.tomshardware.com/pc-components/gpus/nvidia-launches-vera-rubin-nvl72-ai-supercomputer-at-ces-promises-up-to-5x-greater-inference-performance-and-10x-lower-cost-per-token-than-blackwell-coming-2h-2026

- NVIDIA Launches Next-Generation Rubin AI Compute Platform at CES 2026, Zugriff am Januar 8, 2026, https://www.servethehome.com/nvidia-launches-next-generation-rubin-ai-compute-platform-at-ces-2026/

- The Rubin Revolution: NVIDIA Unveils the 3nm Roadmap to Trillion-Parameter Agentic AI at CES 2026, Zugriff am Januar 8, 2026, https://markets.financialcontent.com/wral/article/tokenring-2026-1-5-the-rubin-revolution-nvidia-unveils-the-3nm-roadmap-to-trillion-parameter-agentic-ai-at-ces-2026

- NVIDIA Rubin Is The Most Advanced AI Platform On The Planet: Up To 50 PFLOPs With HBM4, Vera CPU With 88 Olympus Cores, And Delivers 5x Uplift Vs Blackwell, Zugriff am Januar 8, 2026, https://wccftech.com/nvidia-rubin-most-advanced-ai-platform-50-pflops-vera-cpu-5x-uplift-vs-blackwell/

- NVIDIA’s Rubin Platform: The Next Frontier in AI Supercomputing Begins Production, Zugriff am Januar 8, 2026, https://markets.financialcontent.com/wral/article/tokenring-2026-1-2-nvidias-rubin-platform-the-next-frontier-in-ai-supercomputing-begins-production

- NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer, Zugriff am Januar 8, 2026, https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer

- Nvidia Says Rubin Will Deliver 5x AI Inference Boost Over Blackwell, Zugriff am Januar 8, 2026, https://www.hpcwire.com/2026/01/05/nvidia-says-rubin-will-deliver-5x-ai-inference-boost-over-blackwell/

- Nvidia Rubin AI platform lowers token costs tenfold compared to Blackwell as Elon Musk praises it as ‘rocket engine for AI’, Zugriff am Januar 8, 2026, https://www.notebookcheck.net/Nvidia-Rubin-AI-platform-lowers-token-costs-tenfold-compared-to-Blackwell-as-Elon-Musk-praises-it-as-rocket-engine-for-AI.1197748.0.html

- NVIDIA officially unveils Rubin: its next-gen AI platform with huge upgrades, next-gen HBM4, Zugriff am Januar 8, 2026, https://www.tweaktown.com/news/109558/nvidia-officially-unveils-rubin-its-next-gen-ai-platform-with-huge-upgrades-next-gen-hbm4/index.html

- The HBM4 Revolution: How Massive Memory Investments Are Redefining the AI Supercycle, Zugriff am Januar 8, 2026, https://markets.financialcontent.com/wral/article/tokenring-2026-1-7-the-hbm4-revolution-how-massive-memory-investments-are-redefining-the-ai-supercycle

- The HBM4 Memory War: SK Hynix, Micron, and Samsung Race to Power NVIDIA’s Rubin Revolution – FinancialContent, Zugriff am Januar 8, 2026, https://markets.financialcontent.com/wral/article/tokenring-2026-1-8-the-hbm4-memory-war-sk-hynix-micron-and-samsung-race-to-power-nvidias-rubin-revolution

- NVIDIA’s Self-Developed HBM Base Die: nm Process and 2027 Trial Production – Semicon, Zugriff am Januar 8, 2026, https://www.semicone.com/article-275.html

- Next Gen Data Center CPU | NVIDIA Vera CPU, Zugriff am Januar 8, 2026, https://www.nvidia.com/en-gb/data-center/vera-cpu/

- Rack-Scale Agentic AI Supercomputer | NVIDIA Vera Rubin NVL72, Zugriff am Januar 8, 2026, https://www.nvidia.com/en-us/data-center/vera-rubin-nvl72/

- Gigascale AI Training & Inference Platform | NVIDIA DGX Vera Rubin NVL72, Zugriff am Januar 8, 2026, https://www.nvidia.com/en-us/data-center/dgx-vera-rubin-nvl72/

- Nvidia announces full production of Vera Rubin AI platform with TSMC chips, Zugriff am Januar 8, 2026, https://www.tribuneindia.com/news/business/nvidia-announces-full-production-of-vera-rubin-ai-platform-with-tsmc-chips/

- NVIDIA Launches Vera Rubin Architecture at CES 2026: The VR NVL72 Rack, Zugriff am Januar 8, 2026, https://www.storagereview.com/news/nvidia-launches-vera-rubin-architecture-at-ces-2026-the-vr-nvl72-rack

- So… Nvidia is planning on building hardware that is going to be putting some severe stresses on data center infrastructure capabilities: : r/HPC – Reddit, Zugriff am Januar 8, 2026, https://www.reddit.com/r/HPC/comments/1jl75dj/so_nvidia_is_planning_on_building_hardware_that/

- Nvidia unpacks Vera Rubin rack system at CES – The Register, Zugriff am Januar 8, 2026, https://www.theregister.com/2026/01/05/ces_rubin_nvidia/

- Supercomputers can stay chill with hot water says Nvidia, Zugriff am Januar 8, 2026, https://www.fierce-network.com/cloud/nvidia-has-no-chill

- NVIDIA BlueField-4 Powers New Class of AI-Native Storage Infrastructure for the Next Frontier of AI, Zugriff am Januar 8, 2026, https://nvidianews.nvidia.com/news/nvidia-bluefield-4-powers-new-class-of-ai-native-storage-infrastructure-for-the-next-frontier-of-ai

- Introducing NVIDIA BlueField-4-Powered Inference Context Memory Storage Platform for the Next Frontier of AI, Zugriff am Januar 8, 2026, https://developer.nvidia.com/blog/introducing-nvidia-bluefield-4-powered-inference-context-memory-storage-platform-for-the-next-frontier-of-ai/

- NVIDIA Accelerates Robotics Research and Development With New Open Models and Simulation Libraries, Zugriff am Januar 8, 2026, https://nvidianews.nvidia.com/news/nvidia-accelerates-robotics-research-and-development-with-new-open-models-and-simulation-libraries

- NVIDIA Announces Isaac GR00T N1 — the World’s First Open Humanoid Robot Foundation Model — and Simulation Frameworks to Speed Robot Development, Zugriff am Januar 8, 2026, https://nvidianews.nvidia.com/news/nvidia-isaac-gr00t-n1-open-humanoid-robot-foundation-model-simulation-frameworks

- NVIDIA Alpamayo – Open Models for Autonomous Vehicles, Zugriff am Januar 8, 2026, https://www.nvidia.com/en-us/solutions/autonomous-vehicles/alpamayo/

- Building Autonomous Vehicles That Reason with NVIDIA Alpamayo | NVIDIA Technical Blog, Zugriff am Januar 8, 2026, https://developer.nvidia.com/blog/building-autonomous-vehicles-that-reason-with-nvidia-alpamayo/

- Buy Nvidia or AMD Stock After Rolling Out New AI Platforms?, Zugriff am Januar 8, 2026, https://www.tradingview.com/news/zacks:298f8aee8094b:0-buy-nvidia-or-amd-stock-after-rolling-out-new-ai-platforms/

- AMD touts Instinct MI430X, MI440X, and MI455X AI accelerators and Helios rack-scale AI architecture at CES — full MI400-series family fulfills a broad range of infrastructure and customer requirements, Zugriff am Januar 8, 2026, https://www.tomshardware.com/tech-industry/artificial-intelligence/amd-touts-instinct-mi430x-mi440x-and-mi455x-ai-accelerators-and-helios-rack-scale-ai-architecture-at-ces-full-mi400-series-family-fulfills-a-broad-range-of-infrastructure-and-customer-requirements

- Comparison: AMD vs. NVIDIA Performance Per Rack : r/AMD_Stock – Reddit, Zugriff am Januar 8, 2026, https://www.reddit.com/r/AMD_Stock/comments/1p1ekjy/comparison_amd_vs_nvidia_performance_per_rack/

KI-gestützt. Menschlich veredelt.

Martin Käßler ist ein erfahrener Tech-Experte im Bereich AI, Technologie, Energie & Space mit über 15 Jahren Branchenerfahrung. Seine Artikel verbinden fundiertes Fachwissen mit modernster KI-gestützter Recherche- und Produktion. Jeder Beitrag wird von ihm persönlich kuratiert, faktengeprüft und redaktionell verfeinert, um höchste inhaltliche Qualität und maximalen Mehrwert zu garantieren.

Auch bei sorgfältigster Prüfung sehen vier Augen mehr als zwei. Wenn Ihnen ein Patzer aufgefallen ist, der uns entgangen ist, lassen Sie es uns bitte wissen: Unser Postfach ist martinkaessler, gefolgt von einem @ und dem Namen einer bekannten Suchmaschine (also googlemail) mit der Endung .com. Oder besuchen Sie Ihn gerne einfach & direkt auf LinkedIn.